-

Compteur de contenus

226 -

Inscription

-

Dernière visite

-

Jours gagnés

4

Messages posté(e)s par Superthx

-

-

Bonjour.

J'ai beau chercher mais je trouve pas.

Mon Ds1522+ me genere et m'envoi par mail un rapport du dique généré.

Voici l'entête du mail.Un rapport d'utilisation du disque a été généréComment le désactiver et où ?

Merci d'avance.0 -

il y a 6 minutes, PiwiLAbruti a dit :

Le NAS distant est celui qui réplique la zone principale distante (du NAS local) vers sa zone secondaire locale.

La zone WAN est ouvert a tous.

il y a 7 minutes, PiwiLAbruti a dit :Je réplique également des zones DNS entre 3 NAS avec des clés TSIG sans souci, je ne vois pas ce qui peut coincer dans ta configuration.

Perso j'avais jamais eu ce pbl. C'est en modifiant une entrée CNAME sur la zone master que la zone slave ne se mettait pas à jour. J'ai essayer au lieu de la clé via IP et j'ai aussi une erreur.

Les 3 NAS que tu as on quel version de DNS SERVER ? Je vais essayer plus tard de faire un DSM Virtuel voir si cela change au cas ou.0 -

il y a 49 minutes, PiwiLAbruti a dit :

Est-ce que les ports sont également bien ouverts dans les pare-feux de chaque NAS ?

les pare-feux sont desactivé. Avec nmap les ports 53 sont bien ouverts auatant en TCP que UDP

il y a 49 minutes, PiwiLAbruti a dit :L'adresse IP du NAS distant est bien incluse dans la vue à laquelle la zone est associée ?

Quel est le NAS distant pour toi ? Dans chaque NAS j'ai une vue WAN avec Liste d'IP source ALL. Si je met l'ip de l'un ou de l'autre seul les ip mises pourront voir mes zones. Donc le limiter que a une ip.......

En plus c'est bizarre c'est depuis que j'ai mon nouveau NAS en DSM 7.2. Mon ancien NAs ne me la jamais fait.0 -

Merci @PiwiLAbruti

Non du tout.

On va dire que celui qui est sur la zone slave a l'ip 2.2.2.2.

Il a une WAN comme dans le tuto.

Les port 53 TCP et UDP sont bien ouverts dans les deux ip0 -

Bonjour j'ai decouvert recemment un pbl. Et je trouve pas d'où cela vient.

Pour faire simple j'ai configurer un serveur DNS avec une zone maitre sur l'ip publique 1.1.1.1 (adresse fictive, c'est une ip fixe sur un NAS avec la derniere version de DSM 6).

Les requetes marchent sans problemes.

J'ai voulu creer sur un autre NAS une zone esclave et c'est la que cela bloque.

Pour update via ip ou la clé cela ne marche pas. Par exemple avec la clé j'ai ceci dans les logs.

zone mondomaine.com/IN/WAN: refresh: failure trying master 1.1.1.1#53 (source 0.0.0.0#0): expected a TSIG or SIG(0)

Que se passe t'il ? Merci0 -

Merci pour ton retour. Au top

0 -

Le 13/12/2022 à 5:25 PM, Regy a dit :

Finalement, c’est résolu!

j’ai réussi :1. à repasser ma partition en lecture/écriture

2. Puis lancer la réparation

3. En attendant un nouveau disque dur

j’ai planifié un hyperbackup 🤣 @PiwiLAbruti

merci pour vos conseils

C'est cool si tu partage ta solution

0 -

Non rien dans les logs ni deco ni rien avant. Donc je me demande si c'est pas le Btrfs qui deconne. Je dis ça mais en vrai avec mon ds1511+ je n'ai jamais eu de pbl en ext

0 -

Bizarre pourquoi cela...

0 -

1

-

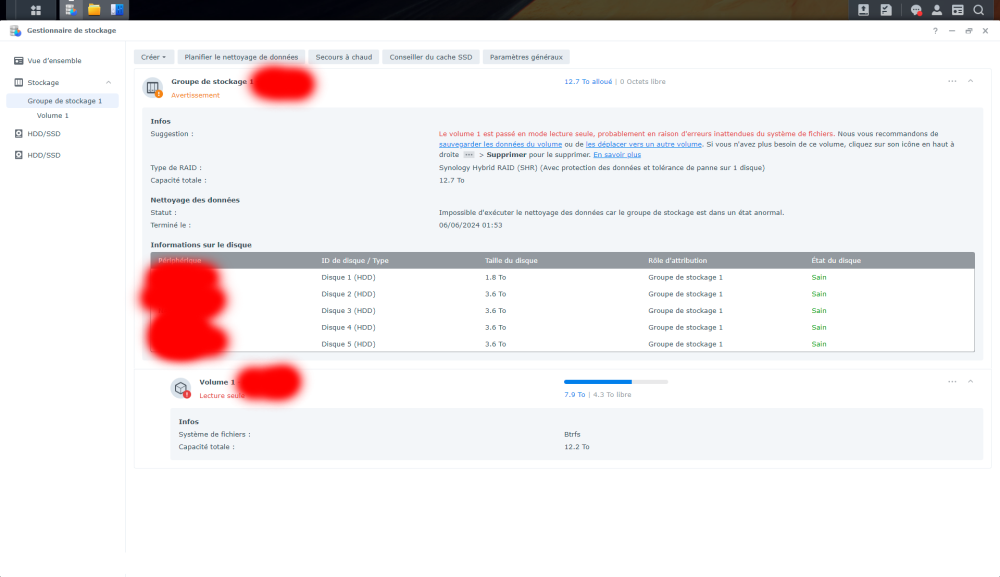

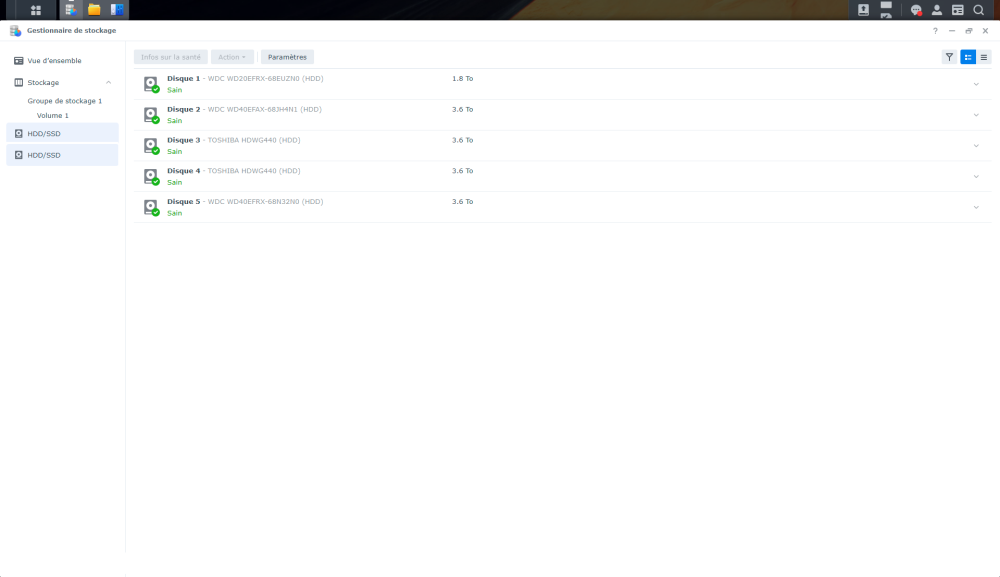

J'ai un enorme probleme.

Ce matin le NAS beep et m'affiche que le volume1 est en lecture seul.

JE pense à un disque defectueux mais rien. Ils sont tous sains.

Que puis je faire.

C'est la cata

0 -

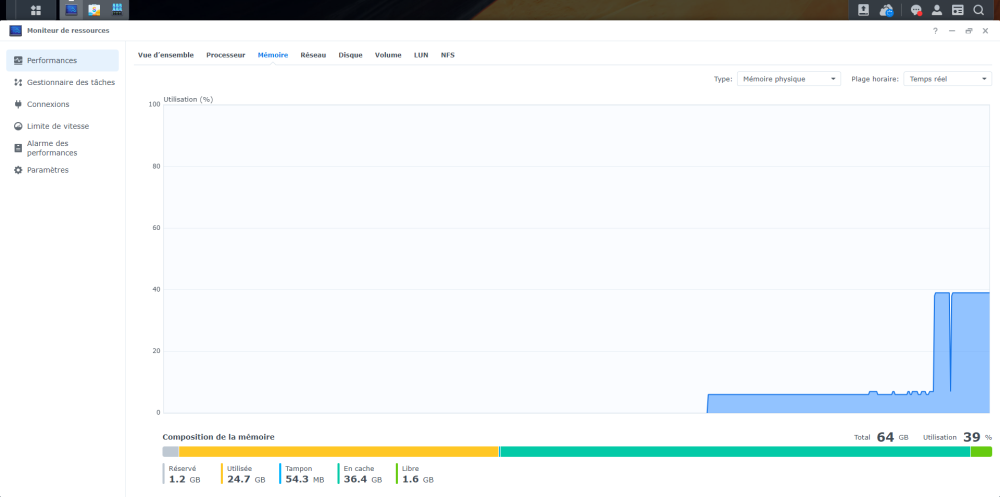

Il y a 19 heures, falcon7 a dit :

Oui en effet. Mais je reviens d'un vieux DS1511+. Avec 3Gb de Ram. A part 20 container docker + 2 machines virtuels je trouve que cela marche bien pour mes besoins. Et je prefere avoir 64 maintenant que chercher plus 1 barette de 32 hors de prix. Mais comme ça vous savez que cela fonctionne avec 64Gb. Par contre avec autant de container et les 2 machines virtuels les arrets/demarrage sont lents. Mais apres tout roule

0 -

Bonjour !

- Marque: Kingston

- Référence: CT16G4SFRA32A.C8FFCT16G4SFRA32A

- Caractéristiques: KCP426SD8/32 SO-DIMM DDR4 2666Mhz 32GB CL19

- Taille: 2x32 go

- Modèle du NAS: DS1522+

- Compatibilité: OUI

sudo cat /var/log/messages | grep 'Memtest' 2024-06-05T08:41:58+02:00 NAS findhostd[15100]: util_fhost.c:1195 Memtest passed! 2024-06-05T08:41:58+02:00 NAS findhostd[15124]: util_fhost.c:1195 Memtest passed! 2024-06-05T08:41:58+02:00 NAS findhostd[15152]: util_fhost.c:1195 Memtest passed! sudo dmidecode -t memory # dmidecode 3.2 Getting SMBIOS data from sysfs. SMBIOS 3.1.1 present. Handle 0x001E, DMI type 16, 23 bytes Physical Memory Array Location: System Board Or Motherboard Use: System Memory Error Correction Type: None Maximum Capacity: 64 GB Error Information Handle: 0x0021 Number Of Devices: 2 Handle 0x001F, DMI type 17, 40 bytes Memory Device Array Handle: 0x001E Error Information Handle: 0x0022 Total Width: 64 bits Data Width: 64 bits Size: 32 GB Form Factor: SODIMM Set: None Locator: DIMM 0 Bank Locator: P0 CHANNEL A Type: DDR4 Type Detail: Synchronous Unbuffered (Unregistered) Speed: 2667 MT/s Manufacturer: Kingston Serial Number: B514FE92 Asset Tag: Not Specified Part Number: 9905744-110.A00G Rank: 2 Configured Memory Speed: 2400 MT/s Minimum Voltage: 1.2 V Maximum Voltage: 1.2 V Configured Voltage: 1.2 V Handle 0x0020, DMI type 17, 40 bytes Memory Device Array Handle: 0x001E Error Information Handle: 0x0023 Total Width: 64 bits Data Width: 64 bits Size: 32 GB Form Factor: SODIMM Set: None Locator: DIMM 0 Bank Locator: P0 CHANNEL B Type: DDR4 Type Detail: Synchronous Unbuffered (Unregistered) Speed: 2667 MT/s Manufacturer: Kingston Serial Number: B5150135 Asset Tag: Not Specified Part Number: 9905744-110.A00G Rank: 2 Configured Memory Speed: 2400 MT/s Minimum Voltage: 1.2 V Maximum Voltage: 1.2 V Configured Voltage: 1.2 V1 -

Salut!

je voulais tester la ram via le synology assistant. Mais au moment du redemarrage il me delai de connexion expiré…

J'ai trouvé.

Si vous avez Un link aggregation fait cela marche pas.2 -

il y a 2 minutes, Jeff777 a dit :

Pour info, chez moi c'est revenu ce matin.

Exact.... Merci pour le retour.

LE jour ou synology ferme on est dans la merde .....0 -

Bonjour !

J'ai un DS1522+.

J'ai pris 2x32Gb KCP426SD8/32Donc je voudrai sqavoir si ceux qui on cette memoire et NAS cela marche bien avec 64Gb.

Donc si @Eric800 ou @Gregoryen Peuvent donner un retour... MErci

0 -

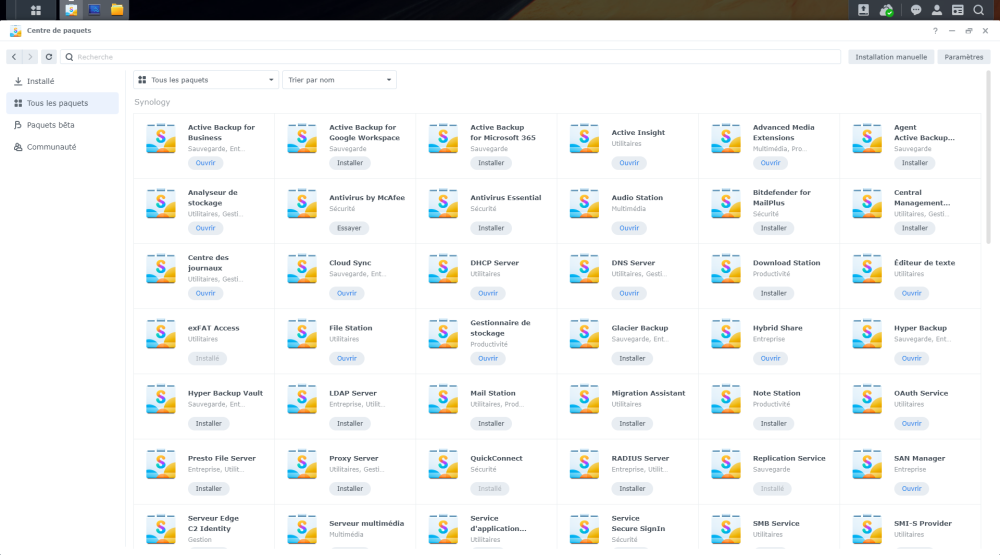

Pourriez vous verifier chez vous si cela se produit ?

voici une partie de mes log :

2024/06/02 07:12:52 Failed to download https://global.synologydownload.com/download/Package/img/SynologyUniversalSearch/1.7.0-0704/thumb_72.png, code=28, err=Error

2024/06/02 07:12:52 Failed to download https://global.synologydownload.com/download/Package/img/SynoSmisProvider/1.1.2-2018/thumb_72.png, code=28, err=Error

2024/06/02 07:12:52 Failed to download image file, url=[https://global.synologydownload.com/download/Package/img/SynologyUniversalSearch/1.7.0-0704/thumb_72.png] path=[/var/cache/synopkg/lfs/image/AVAIL/SYNO/SynoFinder/1.7.0-0704/thumb_64.png]

2024/06/02 07:12:52 Failed to download image file, url=[https://global.synologydownload.com/download/Package/img/SynoSmisProvider/1.1.2-2018/thumb_72.png] path=[/var/cache/synopkg/lfs/image/AVAIL/SYNO/SynoSmisProvider/1.1.2-2018/thumb_64.png]

2024/06/02 07:12:52 Failed to download https://global.synologydownload.com/download/Package/img/PrestoServer/2.1.2-1667/thumb_72.png, code=28, err=Error

2024/06/02 07:12:52 Failed to download image file, url=[https://global.synologydownload.com/download/Package/img/PrestoServer/2.1.2-1667/thumb_72.png] path=[/var/cache/synopkg/lfs/image/AVAIL/SYNO/PrestoServer/2.1.2-1667/thumb_64.png]

2024/06/02 07:12:53 Failed to download https://global.synologydownload.com/download/Package/img/SecureSignIn/1.1.5-0362/thumb_72.png, code=28, err=Error

2024/06/02 07:12:53 Failed to download image file, url=[https://global.synologydownload.com/download/Package/img/SecureSignIn/1.1.5-0362/thumb_72.png] path=[/var/cache/synopkg/lfs/image/AVAIL/SYNO/SecureSignIn/1.1.5-0362/thumb_64.png]

2024/06/02 07:12:53 Failed to download https://global.synologydownload.com/download/Package/img/exFAT-Free/7.2.0-0354/thumb_72.png, code=28, err=Error

2024/06/02 07:12:53 Failed to download image file, url=[https://global.synologydownload.com/download/Package/img/exFAT-Free/7.2.0-0354/thumb_72.png] path=[/var/cache/synopkg/lfs/image/AVAIL/SYNO/exFAT-Free/7.2.0-0354/thumb_64.png]

2024/06/02 07:12:53 Failed to download https://global.synologydownload.com/download/Package/img/SynologyDrive/3.5.0-26084/thumb_72.png, code=28, err=Error

On diarait qu'il ne telecharge pas......Bon apparement c'est Synology qui merde.

Voir ici

https://community.synology.com/enu/forum/1/post/1881260 -

-

Ok trouvé, mis sur max...OUF

0 -

C'est cela qui est bizarre c'est que j'ai 2To qui ont disparu. Il n'y a rien d'autre de disponible. Où je peux retrouver ces 1,8_To @PiwiLAbruti?

M*rde je viens de voir les 1,8 To. Comment les rajouter a mon volume actuel ?

0 -

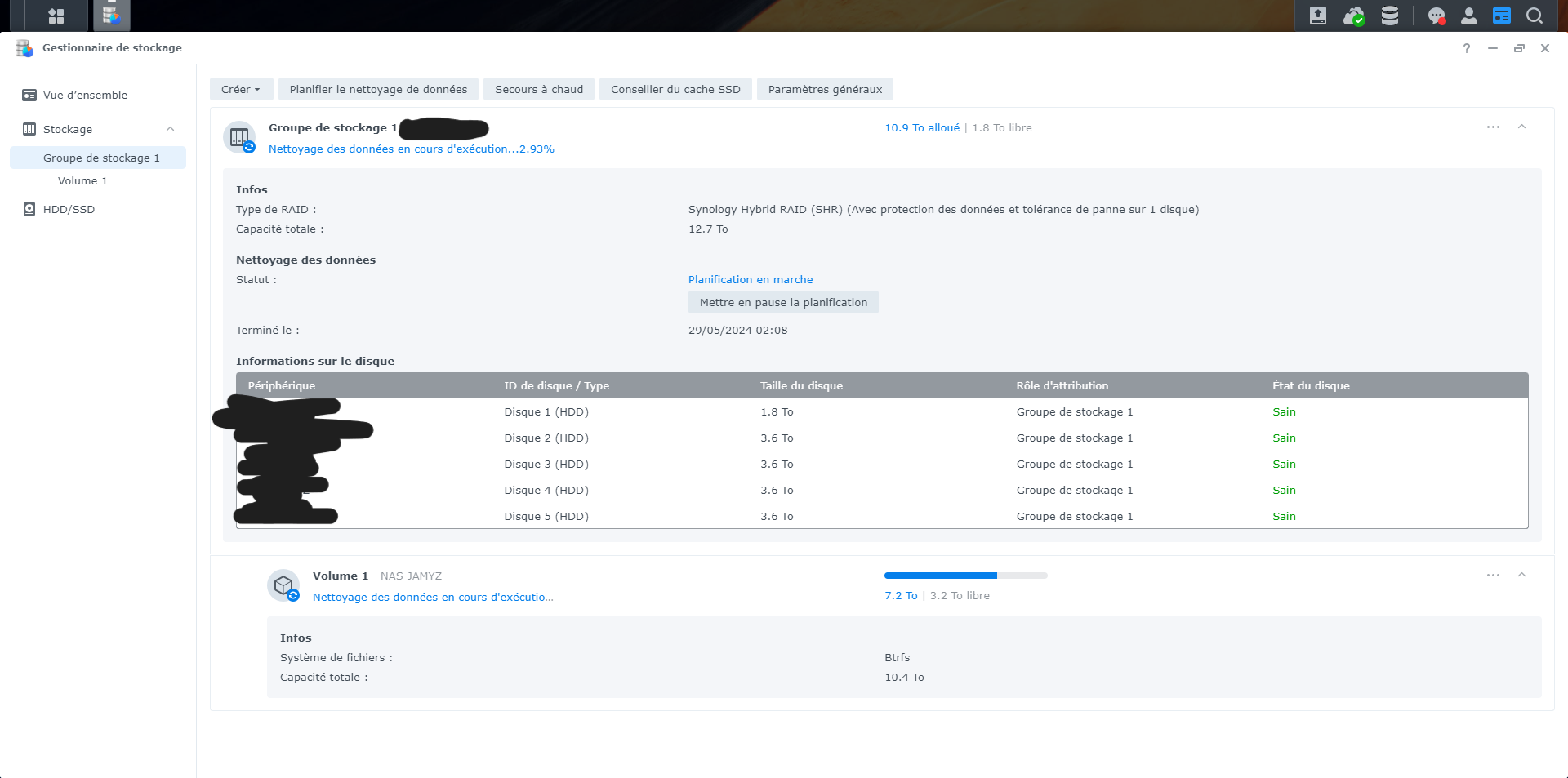

Bonjour !

Je comprends pas la partie du bas.

7.2To | 3.2 To Libre

et capacité totale 10.4To

J'ai 10.4To libre ou 10.9T comme en haut ?

Une explication est bienvenue. MErci...0 -

Bonjour !

J'ai un simple script Python mais il se lance pas au demarrage du NAS.

Pour cela j'ai crée dans le :

Planificateur de tâches ->Créer->Tâche déclenchée->Scipt défini par l'utilisateur

Dans l'onglet Général :

- Tâche ->Scipt_Boot

- Utilisateur -> root

- Evénement -> Démarage

Onglet Paramètres de tâche

- Script défini par l'utilisateurpython3 /volume1/homes/Toto/Scripts/code_boot_py

aussi bien root que utilisateur Toto ne marche pas au demarrage, Mais quand je fais executer cela marche bien.0 -

Oui. Movistar en Espagne

0 -

Finalement c´est mon FAI qui filtre les DNS si pas du même FAI. WTF.....

Vraiment n´importe quoi.

0

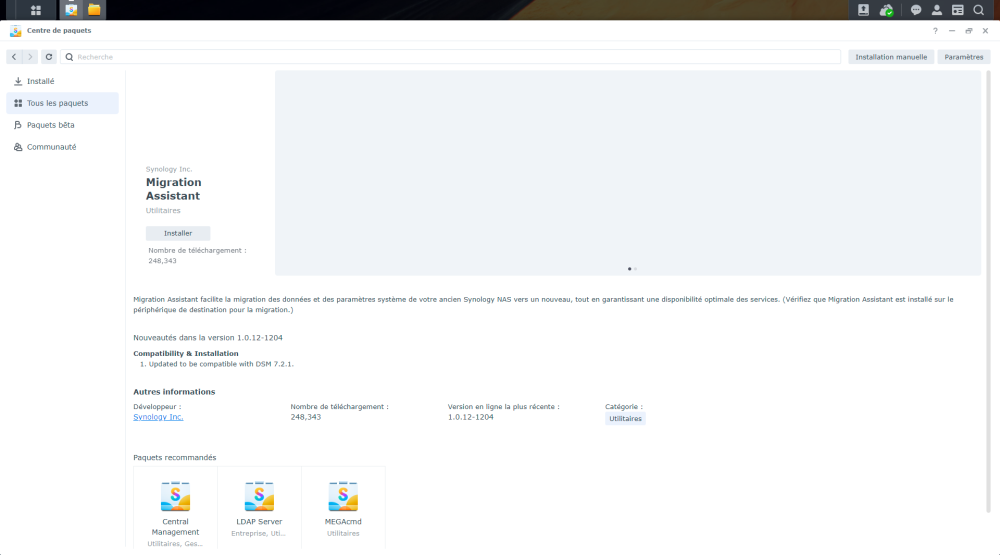

[Résolu]Désactiver rapport du disque généré

dans Installation, Démarrage et Configuration

Posté(e)

Merci beaucoup @PiwiLAbruti