TuringFan

Membres-

Compteur de contenus

385 -

Inscription

-

Dernière visite

-

Jours gagnés

1

Tout ce qui a été posté par TuringFan

-

Affichage photos et vidéos 360° dans Synology Photos

TuringFan a répondu à un(e) sujet de TuringFan dans Synology Photos

Je comprends ton point mais de ce que je lis c'est Synology Photos qui demande des méta données spécifiques (différentes de Google Street View par exemple).- 9 réponses

-

- méta données

- videos

-

(et 3 en plus)

Étiqueté avec :

-

Affichage photos et vidéos 360° dans Synology Photos

TuringFan a répondu à un(e) sujet de TuringFan dans Synology Photos

Merci pour ta réponse @CyberFr, Vraisemblablement le drone n'applique pas les bonnes transformations sur le fichier car la photo n'est pas vue comme 360 dans la pellicule de mon iPhone. En revanche c'est nickel quand je lis la photo avec l'application Simpl360. Je voudrais juste faire la même chose que Simpl360 mais sur Synology Photos de sorte à ce que mes invités sur les albums partagés voient directement le 360° sans effeort ou manipulation spécifique. As tu une idée ?- 9 réponses

-

- méta données

- videos

-

(et 3 en plus)

Étiqueté avec :

-

Affichage photos et vidéos 360° dans Synology Photos

TuringFan a posté un sujet dans Synology Photos

Bonjour à tous, Je fais parfois quelques photos 360° avec mon drone (DJI Fly mini 2) et je souhaiterais que lorsque je partage un album ces fichiers apparaissent directement en 360° pour les utilisateurs. Or ces photos ne sont pas directement reconnues et affichées en tant que 360° avec Synology Photos. Selon le support Synology un fichier sera uniquement marqué à 360 degrés si les métadonnées de la photo EXIF ou de la vidéo contiennent tous les formats à 360 degrés suivants : ProjectionType="equirectangular" FullPanoWidthPixels=CroppedAreaImageWidthPixels FullPanoHeightPixels=CroppedAreaImageHeightPixels Par ailleurs fichier ne sera pas marqué à 360 degrés si les métadonnées de la photo EXIF ou de la vidéo contiennent le format à 360 degrés suivant : UsePanoramaViewer="false" J'ai essayé plusieurs applications et logiciels pour modifier ces méta données mais je ne les vois jamais ! Connaitriez-vous une méthode (idéalement avec une application iOS ou un logiciel simple d'utilisation) pour appliquer ces métadonnées et ainsi afficher en 360° mes photos de drone dans Synology Photos ? Merci d'avance,- 9 réponses

-

- méta données

- videos

-

(et 3 en plus)

Étiqueté avec :

-

Bonjour à tous, J'ai deux sites physiques distants avec des installations similaires dont le même nom de domaine et le même certificat et je ne parviens pas à joindre les services de mon premier site depuis le second bien qu'ils soient accessibles depuis d'autres réseaux LAN / WAN. Par exemple lorsque je souhaite accéder à Synology Drive (hébergé sur le NAS de mon site principal) : Aucun problème depuis le LAN de mon site principal Aucun problème depuis un accès VPN au LAN de mon site principal Aucun problème depuis le WAN -> En revanche impossible d'accéder à mon Drive depuis le LAN de mon site de backup. J'ai l'intuition que c'est le fait d'utiliser le même nom de domaine entraîne les clients à pointer au sein du même LAN (du site de backup) plutôt que de joindre un LAN distant(du site principal). Pouvez-vous svp m'aider ? Ci-dessous ma configuration : Registrar DDNS ndd.tld avec le routeur sur le site principal DDNS prenomnom.synology.me avec le routeur sur le site de backup drive.ndd.tld -> CNAME 0 ndd.tld vpn-backup-ipv6.ndd.tld -> AAAA 0 IPv6 routeur site backup Site principal NAS Synology qui héberge différents services dont Synology Drive NAS Synology qui héberge un reverse proxy qui pointe https://drive.ndd.tld:443 -> http://localhost:X Routeur Synology qui héberge un DNS local avec une zone ndd.tld dont les redirections sont: ndd.tld -> NS 86400 ns.ndd.tld rt.ndd.tld -> CNAME 86400 ns.tld.ndd drive.ndd.tld -> A 86400 @IP NAS site principal vpn-backup-ipv6.ndd.tld -> AAAA 86400 IPv6 routeur site backup Site backup NAS Synology qui héberge les backups du NAS principal Routeur Synology qui héberge un DNS local avec une zone ndd.tld dont les redirections sont : ndd.tld -> NS 86400 ns.ndd.tld rt-backup.ndd.tld -> A 86400 IP routeur site backup vpn-backup-ipv6.ndd.tld -> CNAME 86400 ns.ndd.tld

-

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

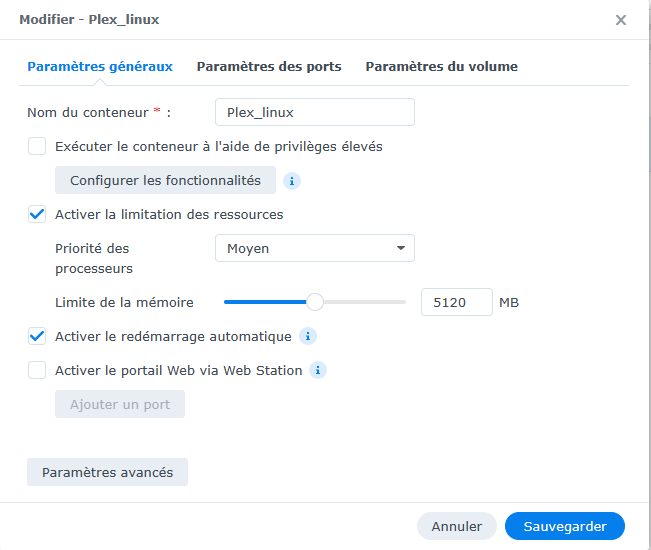

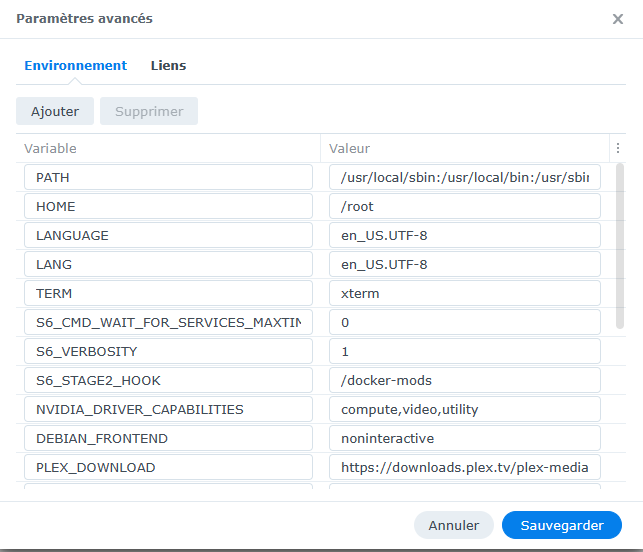

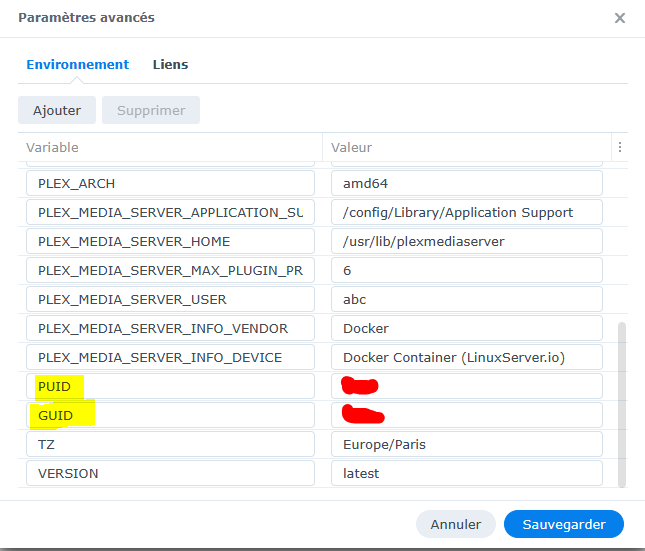

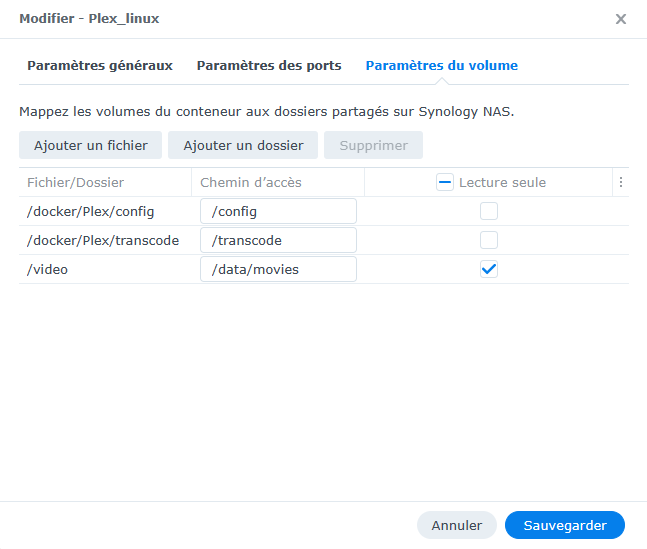

Bonsoir @Einsteinium, Je ne retrouve pas ces éléments dans mon json (cf. ci-dessous pour le contenu de mon fichier). Peux tu stp m'aider ? Faut il utiliser ? "volume_bindings" : [ Merci d'avance, { "CapAdd" : [], "CapDrop" : [], "cmd" : "", "cpu_priority" : 50, "enable_publish_all_ports" : false, "enable_restart_policy" : true, "enable_service_portal" : null, "enabled" : true, "env_variables" : [ { "key" : "PATH", "value" : "/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin" }, { "key" : "HOME", "value" : "/root" }, { "key" : "LANGUAGE", "value" : "en_US.UTF-8" }, { "key" : "LANG", "value" : "en_US.UTF-8" }, { "key" : "TERM", "value" : "xterm" }, { "key" : "S6_CMD_WAIT_FOR_SERVICES_MAXTIME", "value" : "0" }, { "key" : "S6_VERBOSITY", "value" : "1" }, { "key" : "S6_STAGE2_HOOK", "value" : "/docker-mods" }, { "key" : "NVIDIA_DRIVER_CAPABILITIES", "value" : "compute,video,utility" }, { "key" : "DEBIAN_FRONTEND", "value" : "noninteractive" }, { "key" : "PLEX_DOWNLOAD", "value" : "https://downloads.plex.tv/plex-media-server-new" }, { "key" : "PLEX_ARCH", "value" : "amd64" }, { "key" : "PLEX_MEDIA_SERVER_APPLICATION_SUPPORT_DIR", "value" : "/config/Library/Application Support" }, { "key" : "PLEX_MEDIA_SERVER_HOME", "value" : "/usr/lib/plexmediaserver" }, { "key" : "PLEX_MEDIA_SERVER_MAX_PLUGIN_PROCS", "value" : "6" }, { "key" : "PLEX_MEDIA_SERVER_USER", "value" : "abc" }, { "key" : "PLEX_MEDIA_SERVER_INFO_VENDOR", "value" : "Docker" }, { "key" : "PLEX_MEDIA_SERVER_INFO_DEVICE", "value" : "Docker Container (LinuxServer.io)" }, { "key" : "PGID", "value" : "100" }, { "key" : "PUID", "value" : "1046" }, { "key" : "VERSION", "value" : "latest" }, { "key" : "TZ", "value" : "Europe/Paris" } ], "exporting" : false, "id" : "***", "image" : "linuxserver/plex:latest", "is_ddsm" : false, "is_package" : false, "links" : [], "memory_limit" : 5368709120, "name" : "Plex", "network" : [ { "driver" : "host", "name" : "host" } ], "network_mode" : "host", "port_bindings" : [], "privileged" : false, "shortcut" : { "enable_shortcut" : false, "enable_status_page" : false, "enable_web_page" : false, "web_page_url" : "" }, "use_host_network" : true, "volume_bindings" : [ { "host_volume_file" : "/docker/Plex/config", "mount_point" : "/config", "type" : "rw" }, { "host_volume_file" : "/docker/Plex/data", "mount_point" : "/data", "type" : "rw" }, { "host_volume_file" : "/docker/Plex/transcode", "mount_point" : "/transcode", "type" : "rw" }, { "host_volume_file" : "/video/Films", "mount_point" : "/movies", "type" : "ro" }, { "host_volume_file" : "/video/Sagas", "mount_point" : "/sagas", "type" : "ro" }, { "host_volume_file" : "/video/Séries", "mount_point" : "/tv_shows", "type" : "ro" }, { "host_volume_file" : "/video/Documentaires", "mount_point" : "/documentaries", "type" : "ro" }, { "host_volume_file" : "/music", "mount_point" : "/music", "type" : "ro" } ] } -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

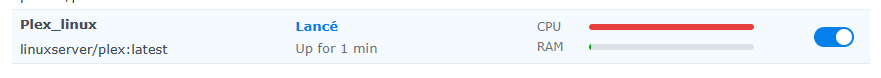

Oui PS : je viens d'edit mon message car ça marche ! -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

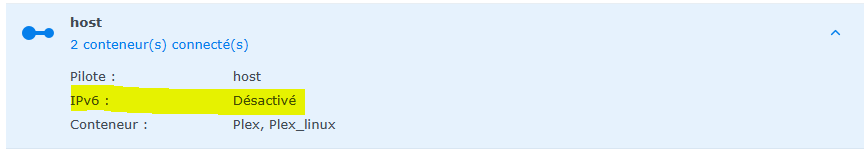

Merci @MilesTEG1 il est bien en host ... Visiblement d'autres rencontrent le même problème plex token not written to preferences on first run · Issue #100 · linuxserver/docker-plex · GitHub Sans comprendre pourquoi j'ai suivi un des posts de cette page en utilisant http://<ip>/web/index.html et là ca a fonctionné ! -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

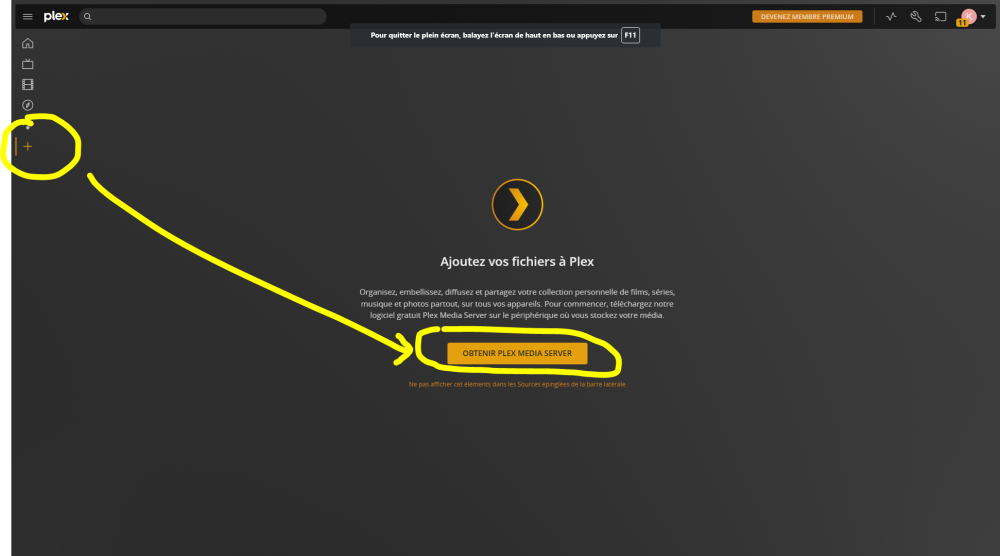

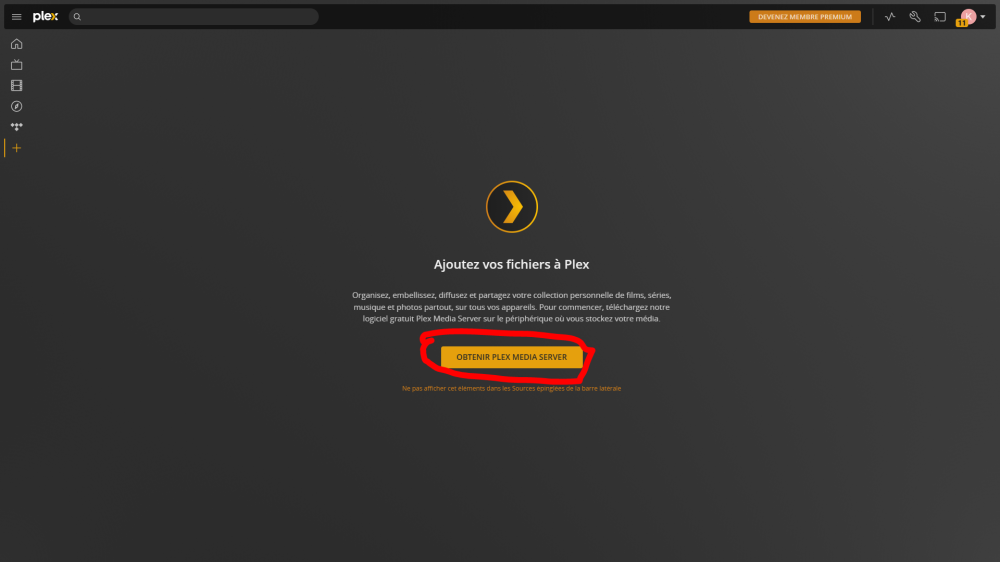

Bonjour @.Shad. et merci pour ton aide. J'ai essayé en me connectant via mon IPv4 et le port 32400 depuis le WAN et toujours le même écran qui m'indique d'obtenir Plex Media Server... D'ailleurs je ne comprends même pas le principe de cette erreur : en effet lors de ma connexion Plex m'indique bien qu'il s'agit d'une application hébergé sur mon serveur et pourtant il me propose après ma connexion d'obtenir PMS ... Un peu contre intuitif non ? Voici mes logs (j'ai remplacé le PUID / GUID avec des *). [migrations] started [migrations] no migrations found ------------------------------------- _ () | | ___ _ __ | | / __| | | / \ | | \__ \ | | | () | |_| |___/ |_| \__/ Brought to you by linuxserver.io ------------------------------------- To support LSIO projects visit: https://www.linuxserver.io/donate/ ------------------------------------- GID/UID ------------------------------------- User uid: **** User gid: *** ------------------------------------- **** Server is unclaimed, but no claim token has been set **** ##################################################### # Login via the webui at http://<ip>:32400/web # # and restart the docker, because there was no # # preference file found, possibly first startup. # ##################################################### [custom-init] No custom files found, skipping... Starting Plex Media Server. . . (you can ignore the libusb_init error) [ls.io-init] done. Error in command line:the argument for option '--serverUuid' should follow immediately after the equal sign Crash Uploader options (all are required): --directory arg Directory to scan for crash reports --serverUuid arg UUID of the server that crashed --userId arg User that owns this product --platform arg Platform string --platformVersion arg Platform version string --vendor arg Vendor string --device arg Device string --model arg Device model string --sentryUrl arg Sentry URL to upload to --sentryKey arg Sentry Key for the project --version arg Version of the product --allowRetries arg Whether we will allow retries Critical: libusb_init failed A quoi correspond la ligne **** Server is unclaimed, but no claim token has been set **** ? Le user NAS et les identifiants Plex pour log in n'ont bien aucun rapport ? Merci d'avance pour ton aide. PS : à noter que mon IPv6 est activée au cas où cela jouerait. -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

C’est à dire ? Envoyé de mon iPhone en utilisant Tapatalk Je ne suis malheureusement pas assez compétent, à date, pour maîtriser cette méthode. As tu un bon titi à me conseiller ? Envoyé de mon iPhone en utilisant Tapatalk -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonsoir @_DR64_, Oui j'ai essayé et j'arrive sur un message d'erreur qui vient peut être du fait, qu'en dehors de mes accès via reverse proxy, les accès sur mon NAS sont limités à du HTTPS depuis des IP LAN / VPN uniquement ? C'est bien le cas. Pas besoin de ce dossier chez moi donc. En ligne avec toi C'est bien ce que j'ai fait : je fais tourner un conteneur sur un docker installé manuellement. Mais je reste bloqué : quand je souhaite visualiser mes media le client Plex web fait comme si le serveur n'était pas installé ... As tu une idée ? -

[TUTO] Plex via docker, avec ou sans transcodage matériel

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

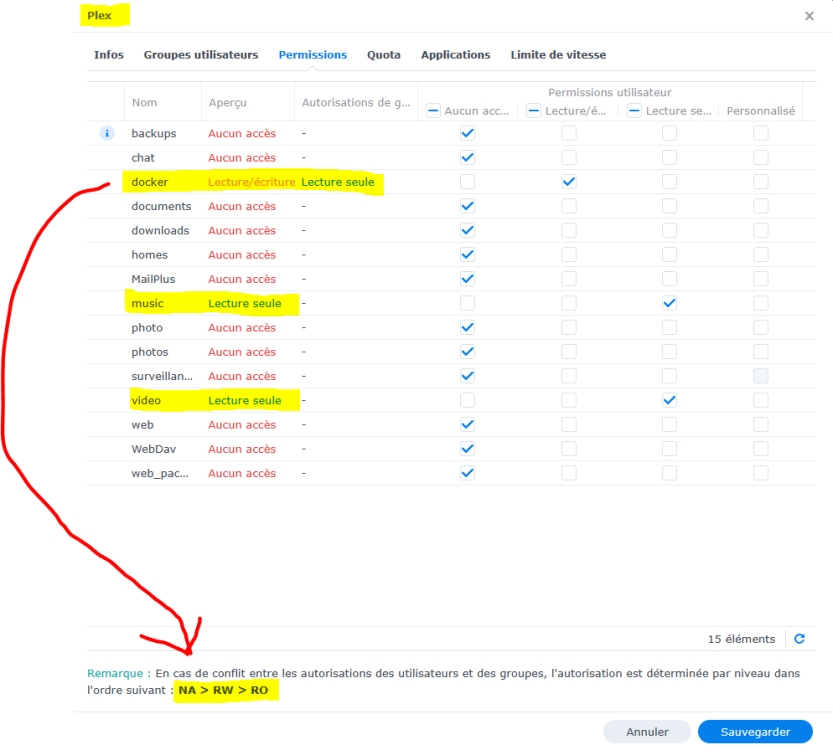

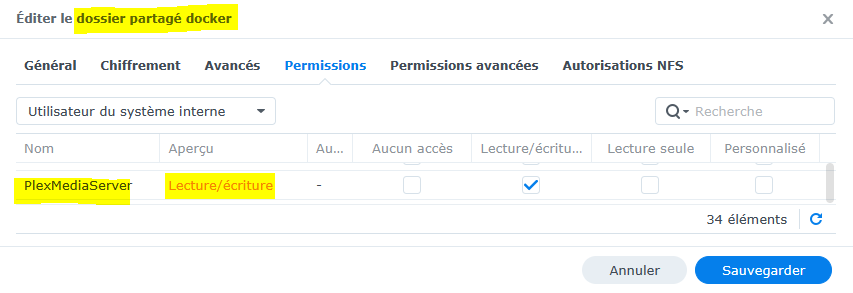

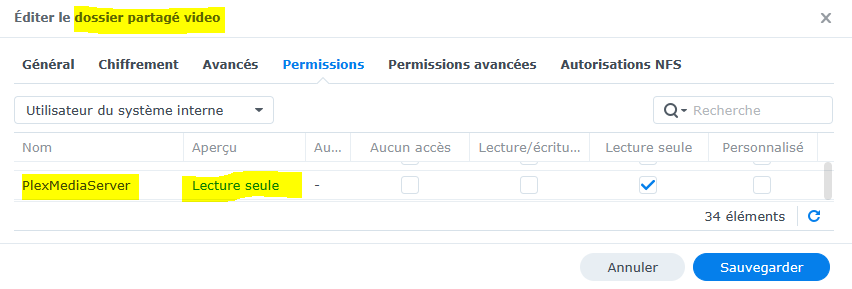

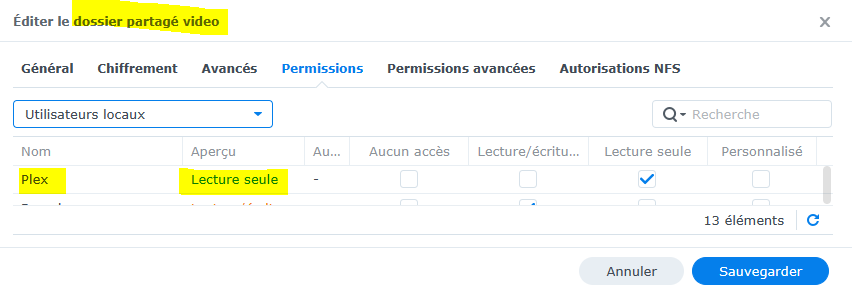

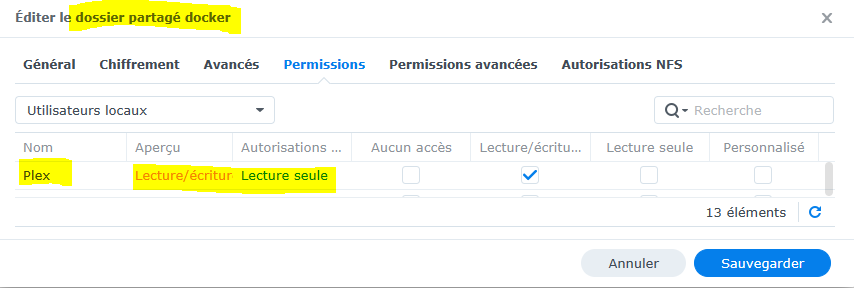

Bonjour @Einsteinium, Mon problème Je viens de suivre ton tuto qui semble super cool mais malheureusement mon client web Plex fait comme si mon serveur n'était pas installé. Sais tu ce qui pourrait bloquer ? Ma configuration NAS DS418play DSM 7.1.1-42962 Update 1 NAS avec IPv4 activée / IPv6 activée Accès via reverse proxy + DNS registrar + DNS local : https://plex.ndd.tld:443 -> https://localhost:32400 Après test sur ce site https://plex.ndd.tld pointe bien vers une IPv4 Conteneur en host Captures d'écran ci-dessous des paramètres docker et droits du user dédié "Plex" Captures docker Le nom des variables est il bien le bon (car ta capture indique "PGID et non "PUID") ? Captures DSM Autres questions A quoi sert ton dossier certificat ? -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

@oracle7 Tu m’avais effectivement répondu. J’ai vu ton MP après et j’ai oublié d’éditer ce message. Pardon pour la redondance. Concernant l’arrêt du docker ok c’est noté. Merci Envoyé de mon iPhone en utilisant Tapatalk -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Hello @oracle7, As tu trouvé une méthode pour déployer automatiquement sur tous tes appareils (dont les routeurs) ? @oracle7 et @Riddox sauriez-vous comment résoudre ce problème ? Merci d'avance, -

Sécuriser les accès (physiques) à son NAS

TuringFan a répondu à un(e) sujet de TuringFan dans Installation, Démarrage et Configuration

@maxou56 Merci pour tes réponses et pardon pour le retour tardif (j'ai apparemment mal paramétré les notification du forum). Je n'ai pas accès à l'explorateur de version mais à tous les fichiers sous-jacents : j'imagine donc qu'on peut aller y lire les informations après décompression ? C'est justement contre ce risque que je veux me protéger : car si je comprends bien sans chiffrement d'un dossier celui-ci pourrait être lu en clair (i) après reset du NAS et reparamétrage du mot de passe admin ou (ii) sur un autre NAS dont on a les droits admin. Est-ce bien cela ? Autre question : sur mon NAS principal certain de mes dossiers sont chiffrés mais j'imagine que ce chiffrement n'est pas conservé sur le backup puisqu'au moment de la sauvegarde ils sont "montés" donc "déchiffrés". Est-ce bien cela ? Je ne suis pas certain de comprendre pourrais tu stp m'expliquer la différence entre le chiffrement du dossier directement sur le NAS de backup et le chiffrement côté client demandé depuis l'émetteur de la tache de sauvegarde (qui si je comprends bien doit également chiffrer la cible de la sauvegarde) ? Super interessant, je ne savais pas. Est-il possible de chiffrer les enregistrements directement sur mon NAS de sauvegarde (en passant par le WAN pour atteindre un autre LAN que les caméras) et non sur mon NAS principal (sur le même LAN que mes caméras) ? En effet en enregistrant sur le NAS principal si un voleur le dérobe, le NAS probablement pas encore sauvegardé les images qui montrent ce vol et je n'y aurais donc pas accès pour les utiliser ensuite auprès de mon assurance ...- 10 réponses

-

Sécuriser les accès (physiques) à son NAS

TuringFan a répondu à un(e) sujet de TuringFan dans Installation, Démarrage et Configuration

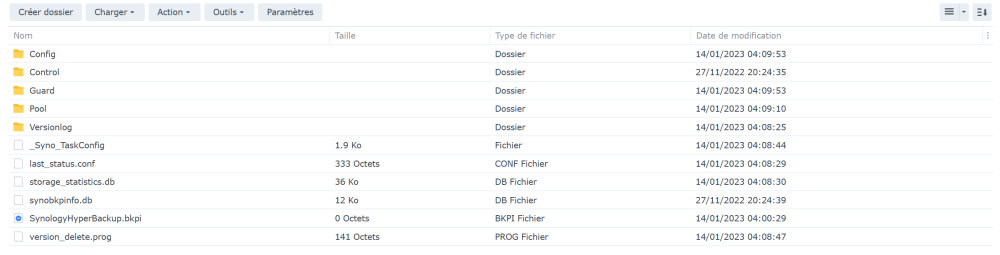

Bonjour @maxou56, Je me permets de revenir vers toi à ce sujet car j'ai implémenté ma stratégie de sauvegarde. Ma configuration Je possède un NAS principal sur lequel est installé Hyper Backup. J'ai configuré sur ce NAS principal un backup quotidien vers un NAS de backup distant (autre LAN). J'ai paramétré ma tâche de backup pour avoir une authentification via (i) un utilisateur dédié (nommé "User_backup"), avoir (ii) un chiffrement du transport et (iii) un chiffrement coté client. Sur mon NAS de backup le dossier partagé destination de la tache de backup (nommé "Backup_basic") est non chiffré. Mes observations Lorsque je me connecte sur mon NAS principal et accède à Hyper Backup je peux explorer ma sauvegarde à distance uniquement après avoir renseigné ma clé de chiffrement coté client. Lorsque je me connecte sur mon NAS de backup (client de ma tâche de backup) via le compte admin (accès au dossier partagé "Backup_basic" et à l'application Hyper Backup Vault) je peux explorer ma sauvegarde locale uniquement après avoir renseigné ma clé de chiffrement coté client. En revanche lorsque je me connecte sur mon NAS de backup (client de ma tâche de backup) via le compte User_backup (utilisateur utilisé pour l'authentification de ma tâche de backup) je peux explorer ma sauvegarde locale en clair via files station sans avoir renseigné ma clé de chiffrement coté client ! Mes questions Pourquoi n'ai-je pas besoin de renseigner ma clé de chiffrement pour explorer ma sauvegarde en me connectant avec mon User_backup ? Comment empêcher ce comportement et systématiquement demander une clé de chiffrement pour lire la sauvergarde (notamment en cas d'accès physique au volume et/ou en cas de mot de passe corrompu de l'utilisateur User_backup) ? Dois-je, en plus du chiffrement du transport et du chiffrement côté client, chiffrer le dossier partagé destination de la tache de sauvegarde ? PS Je crois par ailleurs comprendre que DSM 7.2 devrait prévoir une nouvelle fonctionnalité de chiffrement d'un volume entier ce qui devrait être top car de mémoire certain dossier partagés sont à date non chiffrables (Surveillance Station, MailPlus, etc.).- 10 réponses

-

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour @d_mu, Je ne suis pas certain de bien comprendre ton problème mais le dynhost est une technologie, cela permet à ton appareil (NAS, Routeur, etc.) d'indiquer à ton Registrar (OVH, etc.) ton IP externe : la plupart des FAI ne fournissent en effet pas d'IP externe statiques (l'IP est généralement modifiée au redémarrage de ta box par exemple). Bref le domaine que tu dois indiquer est celui que tu as acheté auprès de ton registrar ou que tu as via Synology. Sauf si tu as explicitement indiqué "dynhost" dans ton nom de domaine a priori tu n'en as pas besoin. Concernant ta connexion non sécurisée, je ne suis pas assez sachant pour t'aider mais je te conseille d'essayer de te connecter depuis un autre ordinateur et/ou autre navigateur pour voir si le problème persiste ou non. C'est peut être simplement que ton certificat est expiré (dans ce cas ton NAS te l'indique explicitement dans le menu dédié au certificats). Bonne journée, -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour à tous, Je me permets de poster ici mon retour d'expérience sur ce tuto. Voici ce que je crois comprendre On utilise Docker pour faire tourner en continue une image : en gros cela sert à faire tourner un programme (l'image) en s'affranchissant de l'environnement (notamment des différentes versions de DSM). L'image que l'on va exécuter va utiliser le protocole ACME et une API avec notre registrar (ici OVH) pour gérer notre certificat. L'exécution quotidienne (ici à 5h00) d'une tache va permettre de d'éteindre le docker contenant l'image ACME, de télécharger la dernière version puis de redémarrer le conteneur. On va ensuite initialiser le processus en (i) créant un certificat puis (ii) en le déployant. Ces deux opérations sont faites via du code SSH ou de façon équivalente en lançant ponctuellement une tache qui contient ce code via l'utilisateur root. Le nombre de création de certificat est limité par période de 7 jours glissants et les certificats ont une durée de vie de 3 mois. Est-ce correct ? Voici mes questions Est-ce que c'est l'image ACME qui qui se charge de vérifier la date d'expiration du certificat ? Est-ce que c'est l'image ACME qui qui se charge, en plus de créer un nouveau certificat, de le déployer ? Bug #1 Comme @Riddox je reçois à chaque exécution de ma tache quotidienne un message qui m'indique que "le conteneur Docker Acme s'est arrêté de manière inattendue". Savez-vous comment résoudre ce problème ? Bug #2 Comme @oracle7 (i) mon fichier header reste vide et (ii) mon déploiement automatique via la tache ne semble pas fonctionner. Voici ce que j'ai dans mes logs : [Mon Dec 19 15:26:54 UTC 2022] Running cmd: deploy [Mon Dec 19 15:26:54 UTC 2022] Using config home:/acme.sh [Mon Dec 19 15:26:54 UTC 2022] default_acme_server='https://acme-v02.api.letsencrypt.org/directory' [Mon Dec 19 15:26:54 UTC 2022] ACME_DIRECTORY='https://acme-v02.api.letsencrypt.org/directory' [Mon Dec 19 15:26:54 UTC 2022] DOMAIN_PATH='/acme.sh/ndd.tld' [Mon Dec 19 15:26:54 UTC 2022] _deployApi='/root/.acme.sh/deploy/synology_dsm.sh' [Mon Dec 19 15:26:54 UTC 2022] _cdomain='ndd.tld' [Mon Dec 19 15:26:54 UTC 2022] SYNO_Certificate='ACMEWilcardndd.tld' [Mon Dec 19 15:26:54 UTC 2022] _base_url='http://---.---.--.--:5000' [Mon Dec 19 15:26:54 UTC 2022] Getting API version [Mon Dec 19 15:26:54 UTC 2022] GET [Mon Dec 19 15:26:54 UTC 2022] url='http://---.---.--.--:5000/webapi/query.cgi?api=SYNO.API.Info&version=1&method=query&query=SYNO.API.Auth' [Mon Dec 19 15:26:54 UTC 2022] timeout= [Mon Dec 19 15:26:54 UTC 2022] _CURL='curl --silent --dump-header /acme.sh/http.header -L ' [Mon Dec 19 15:29:02 UTC 2022] Please refer to https://curl.haxx.se/libcurl/c/libcurl-errors.html for error code: 28 [Mon Dec 19 15:29:02 UTC 2022] ret='28' [Mon Dec 19 15:29:02 UTC 2022] Logging into ---.---.--.--:5000 [Mon Dec 19 15:29:02 UTC 2022] POST [Mon Dec 19 15:29:02 UTC 2022] _post_url='http://---.---.--.--:5000/webapi/auth.cgi?enable_syno_token=yes' [Mon Dec 19 15:29:02 UTC 2022] _CURL='curl --silent --dump-header /acme.sh/http.header -L ' Selon cette page mon erreur (28) est une erreur de time out. Savez-vous comment résoudre ce problème ? Merci d'avance, -

utiliser un VPN uniquement pour Download Station

TuringFan a répondu à un(e) sujet de benguedj dans Download Station

@limannzerga, Pardon mais je ne serai pas d'une grande aide. J'ai désinstallé download sans jamais avoir réussi à le faire automatiquement fonctionner en client VPN. -

Stratégies de sauvegarde du NAS

TuringFan a répondu à un(e) sujet de TuringFan dans Installation, Démarrage et Configuration

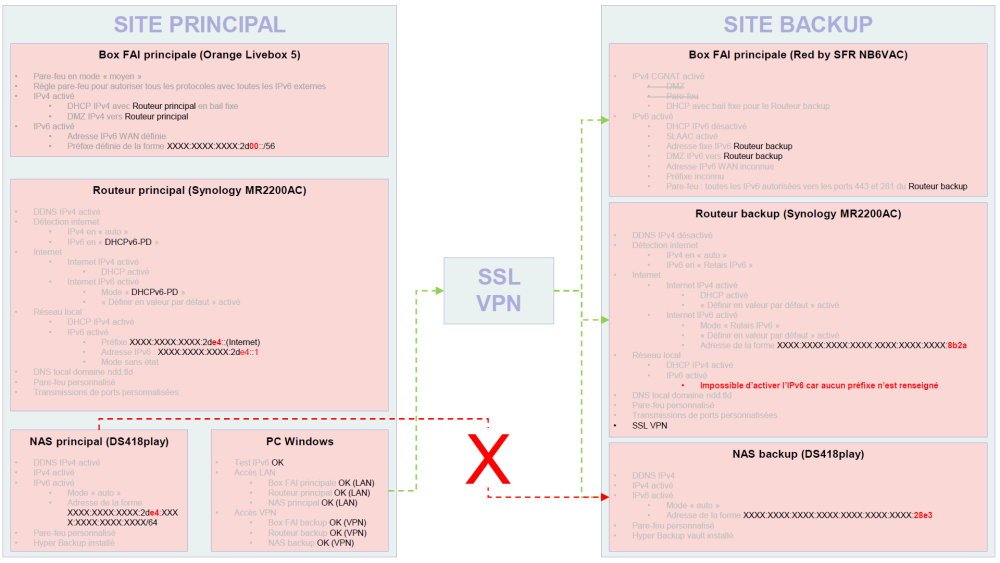

Bonjour à tous, Pour info j'ai monté mon réseau de backup ce WE et je suis tombé sur un os : ce réseau accès à internet via le FAI Red by SFR qui fourni une box qui ne premter pas une bonne gestion de l'IPv4, j'ai donc été obligé de passer par de l'IPv6. J'ai aujourd'hui accès à ce second réseau via un SSL VPN parfaitement fonctionnel (accès Box, SRM et DSM) mais je ne parviens toujours pas à connecter mon NAS principal à mon NAS de backup via Hyper Backup. J'ai expliqué mon problème ici. Je suis preneur de votre aide si vous avez des idées ... Merci d'avance, -

Configuration du nas en IPv6

TuringFan a répondu à un(e) sujet de misterg94 dans Installation, Démarrage et Configuration

Bonjour, Je rencontre un problème similaire et je suis preneur de votre aide. Contexte Je souhaite utiliser Hyper Backup pour sauvegarder mon NAS "principal" sur un NAS "backup" (comme expliqué ici). Ce second NAS est sur un réseau distant dont le FAI est Red by SFR. La box NB6 fournie par Red by SFR ne propose pas une gestion complète de l'IPv4 (pas de DMZ, pas de DHCP, pas de pare-feu, etc.) et je suis donc obligé de passer par le l'IPv6. J'ai configuré un VPN sur le routeur du réseau distant et je parviens à m'y connecter depuis le LAN de mon NAS principal ou le WAN. Ce VPN me donne également accès à (i) l'interface de gestion de la box Red by SFR et (ii) le DSM de mon NAS backup. Questions Il semble impossible d’activer l'IPv6 sur le routeur du réseau backup : la valeur du préfixe reste vide et n'est pas pré-renseignée (comme c'est le cas sur mon réseau principal avec une Livebox 5) : comment faire pour activer IPv6 sur le réseau local backup ? Mon NAS backup (monté derrière ce routeur) affiche néanmoins une adresse IPv6 et le ping via ce site fonctionne : est-ce normal ? Mon NAS principal ne parvient pas à se connecter sur l'IPv6 du NAS backup via Hyper Backup : comment faire ? Ma configuration Merci d'avance pour votre aide. -

Stratégies de sauvegarde du NAS

TuringFan a répondu à un(e) sujet de TuringFan dans Installation, Démarrage et Configuration

Merci @.Shad. et @PiwiLAbruti -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour @Einsteinium, Désolé de t'embêter avec ça mais j'ai cherché sans trouver de solution (y compris du support OVH qui ne s'occupe pas des sujets API) : comment supprimer des clés API chez OVH ? J'en ai créé deux par erreur. Cordialement, -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Merci @Einsteinium -

Stratégies de sauvegarde du NAS

TuringFan a répondu à un(e) sujet de TuringFan dans Installation, Démarrage et Configuration

Bonjour à tous, Je reviens sur ce sujet. Je viens de commander un onduleur, un routeur MR2200ac et un NAS DS220 pour les installer sur un réseau fibré distant de plusieurs centaines de km de mon domicile (où j'ai mon NAS principal). Je souhaite me préparer au mieux car je vais avoir une fenêtre de temps assez réduite pour faire l'installation. Voici ce que j'envisage : Installer l'onduleur Installer le routeur Sécuriser le routeur Créer une connexion VPN (pour assister à ce réseau depuis mon domicile) Installer le NAS Sécuriser le NAS Exécuter Synology backup sur le NAS principal pour effectuer des backups quotidiens sur le NAS distant (qui exécutera alors Synology backup Vault) Surveiller mes deux NAS via Active Insight Si possible enregistrer les fichiers d'enregistrement de ma caméra IP (située à mon domicile) directement sur le NAS distant puis en faire un backup quotidien sur mon NAS principal. J'ai plusieurs questions : Puis-je utiliser pour mon NAS de backup le même certificat que sur mon NAS principal ? Sinon comment faire ? Je possède un unique nom de domaine, comment paramétrer le DDNS de mon second NAS ? J'ai vu que Synology Backup permettait de chiffrer les sauvegardes : la sauvegarde est elle bien chiffrée dès le départ (sur le NAS émetteur) de sorte à ce qu'une interception du flux de sauvegarde ne soit pas un danger ou faut il monter une liaison VPN permanente ? Est-il possible d'installer Surveillance Station sur un réseau différent de la caméra et de chiffrer le transport du flux (VPN ou autre) ? Merci d'avance pour votre aide, -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

TuringFan a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour @Einsteinium et merci pour ce tuto. Merci car je viens de le suivre avec succès et à mes yeux il s'agit d'un tuto facile/rapide à déployer ! J'ai néanmoins des questions (en gras ci-dessous) assez naïves pour bien comprendre ce que j'ai fait. je suis certain que cela pourra en aider d'autres. Je viens de migrer sur DSM 7 et j'utilisais historiquement le tuto de @oracle7 qui marchait plutôt bien de mon côté. je cherchais justement une méthode moins dépendante de l'environnement (et des migrations) et si je comprends bien c'est le gros point fort de cette méthode est qu'elle utilise les dockers (technologie que je ne maitrise absolument pas) . A noter pour ceux dont le NAS n'est pas officiellement/nativement compatible avec Docker, vous pouvez télécharger le paquet sur le centre de téléchargement Synology (en indiquant un NAS compatible) et ensuite l'installer manuellement depuis le centre de paquet. Cela semble fonctionner chez moi. L'utilisation de docker apporte-t-elle autre chose que je n'ai pas indiqué/compris ? Je n'ai pas compris l'utilité et la fonction de cette partie (que j'ai donc ignorée) ? Est-ce un équivalent, via un outil type Portainer, à la création du conteneur acme.sh via le planificateur de tache DSM ? Par ailleurs si j'ai bien compris la configuration obtenu en suivant ce tutoriel permet une renouvellement puis déploiement automatique du certificat sur le NAS. Sauf erreur de ma part le renouvellement est alors assuré par l'appel du script acme.sh via la tache récurrente (programmée quotidiennement à 5h dans le tuto). Question naïve mais où est hébergé le script acme.sh ? Comment celui-ci fonctionne-t-il : j'imagine qu'il fait un check de la date d'échéance du Certificat et le renouvelle quand on s'en approche ? Si oui de combien de temps avant l'échéance le renouvellement est il autorisé ? Est-ce paramétrable ? Après avoir renouvelé puis déployé manuellement le certificat j'ai exécuté la tache de déploiement automatique mais il ne s'est absolument rien passé ... Est-ce normal ? Serait-il par ailleurs possible d'automatiser le déploiement à mon routeur Synology qui est en amont de mon NAS sur mon réseau ? D'un point de vue sécurité je crois comprendre qu'on ne peut pas chiffrer le dossier partagé Docker. Hors celui-ci contient des éléments confidentiels comme (i) les fichiers du certificat ou (ii) les clés API de notre registraire (OVH dans ce tuto). J'ai aussi noté que le fichier de config faisait référence à du HTTP (avec un port 5000) plutôt que du HTTPS (avec un port 5001). Je ne maitrise pas ces sujets mais est-il possible d'améliorer la sécurité de cette configuration (chiffrement dossier partagé + protocole HTTPS) ? Une autre question naïve mais comment désactiver un jeu de clés API chez OVH ? Enfin une question plus générale : je viens de commander un routeur et un second NAS (plus petit) que je compte mettre sur un site distant de mon premier NAS pour effectuer des backups. Pourrais-je me utiliser le même certificat ? Si la réponse est non, comment faire ? Je me permets de taguer @bruno78 car au regard de tes commentaires tu pourrais avoir la réponse ... Merci d'avance pour votre aide,