Tout ce qui a été posté par CoolRaoul

-

Reverse DNS ipv6

Désolé alors, j'ai mal interprété le fait d'être mentionné avec référence à mon fournisseur d'accès : Je patauge trop décidément, je me désabonne du fil, il vaut mieux.

-

Reverse DNS ipv6

Bon je renonce à chercher à comprendre. Quand j'ai utilisé "heise.de" comme exemple je n'imaginais pas que Free puisse être impliqué. J'ai bien des lacunes dans l'architecture DNS je reconnais volontiers.

-

Reverse DNS ipv6

C'est parce que tu parles de Free dans ton post précédent. Il me semble (jusqu'à preuve du contraire) que ma configuration DNS est totalement indépendante de Free, même si c'est mon FAI. Mais bon, peut-être que je maîtrise le sujet moins bien que les autres intervenants de ce fil.

-

Reverse DNS ipv6

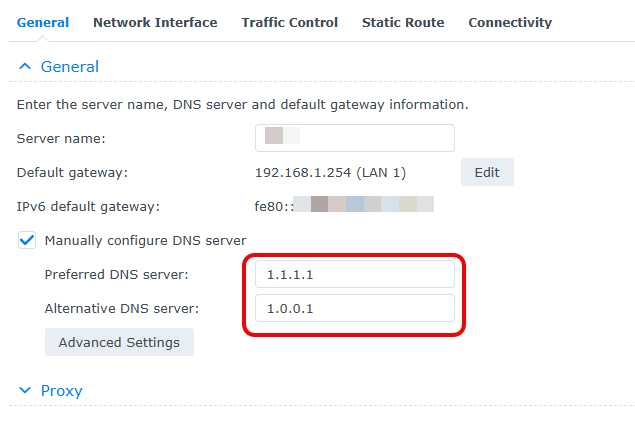

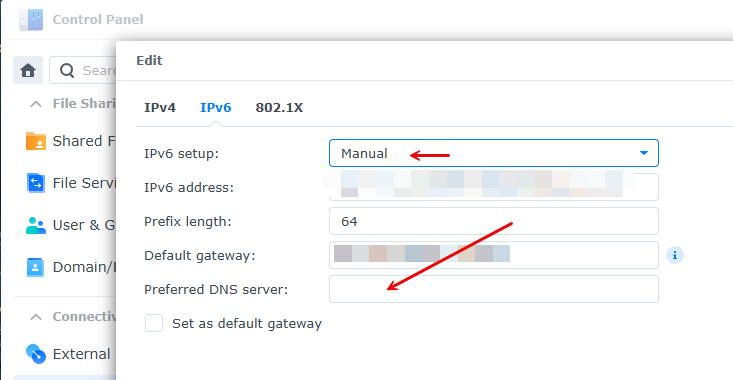

Comme j'utilise les serveurs de Cloudflare et pas ceux de Free pour la résolution DNS je ne comprends pas comment Free pourrait etre dans la boucle.

-

Reverse DNS ipv6

J'ai l'impression que vous n'avez pas percuté que "heise.de" n'est pas mon domaine. Je l'ai juste pris comme exemple pour mes tests de requête DNS quand j'utilise Cloudflare comme serveur DNS

-

Reverse DNS ipv6

Je suis désolé mais tout cela est du chinois pour moi. J'ai bien un nom de domaine mais il y a longtemps que je n'utilise plus dans la configuration de mon NAS. Sur ce dernier j'ai entièrement migré sur synology.me pour les quelques services que j'y héberge et auxquels je veux pouvoir éventuellement accéder de l'extérieur. Mon NDD est désormais utilisé exclusivement pour l'activité professionnelle de mon épouse qui n'a aucune interaction avec le NAS. Tu peux toujours si tu veux me poser des questions précises du style "quelle valeur as-tu appliquée à tel ou tel ou tel paramètres de ta configuration DSM ?" auxquelles je répondrai bien volontiers, mais il faudra être explicite et précis pour que je sois capable de donner la réponse.

-

Reverse DNS ipv6

Je suis désolé de devoir avouer que je ne comprends pas ta question. Je n'ai rien fait de plus que déclarer les DNS Cloudflare dans la config réseau du NAS : On constate d'ailleurs que c'est l'un d'eux et pas un DNS perso interne qui répond dans l'output de dig: SERVER: 1.1.1.1#53(1.1.1.1) (UDP) Tout le reste de la config réseau est native (j'ai aussi déclaré les DNS Cloudflare dans ma box, mais ça ne s'applique uniquement à mes équipements qui auto-configurent via DHCP ce qui n'est pas le cas de mon Syno)

-

Reverse DNS ipv6

Avec mon DNS configuré pour requêter sur Cloudflare pour IPV6 il me semble que le reverse fonctionne (du moment que l'enregistrement du domaine en question soit complet) (sous réserve que j'ai bien tout compris, j'ai pas mal de lacunes sur ces aspects) $ dig heise.de AAAA ; <<>> DiG 9.17.22 <<>> heise.de AAAA ;; global options: +cmd ;; Got answer: ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 12783 ;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1 ;; OPT PSEUDOSECTION: ; EDNS: version: 0, flags:; udp: 1232 ;; QUESTION SECTION: ;heise.de. IN AAAA ;; ANSWER SECTION: heise.de. 74771 IN AAAA 2a02:2e0:3fe:1001:302:: ;; Query time: 14 msec ;; SERVER: 1.1.1.1#53(1.1.1.1) (UDP) ;; WHEN: Thu Mar 13 12:42:26 CET 2025 ;; MSG SIZE rcvd: 65 $ dig -x 2a02:2e0:3fe:1001:302:: ; <<>> DiG 9.17.22 <<>> -x 2a02:2e0:3fe:1001:302:: ;; global options: +cmd ;; Got answer: ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 35772 ;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1 ;; OPT PSEUDOSECTION: ; EDNS: version: 0, flags:; udp: 1232 ;; QUESTION SECTION: ;0.0.0.0.0.0.0.0.0.0.0.0.2.0.3.0.1.0.0.1.e.f.3.0.0.e.2.0.2.0.a.2.ip6.arpa. IN PTR ;; ANSWER SECTION: 0.0.0.0.0.0.0.0.0.0.0.0.2.0.3.0.1.0.0.1.e.f.3.0.0.e.2.0.2.0.a.2.ip6.arpa. 86400 IN PTR redirector.heise.de. ;; Query time: 219 msec ;; SERVER: 1.1.1.1#53(1.1.1.1) (UDP) ;; WHEN: Thu Mar 13 12:42:36 CET 2025 ;; MSG SIZE rcvd: 134

-

Reverse DNS ipv6

Il y a la solution de s'appuyer sur un DNS public comme Cloudflare par exemple en remplacement de celui du FAI, https://developers.cloudflare.com/1.1.1.1/ip-addresses/ A faire soit sous DSM Soit (mieux comme ça tous les équipements du réseau domicile en profitent) sur la BOX du FAI si elle le permet

-

Radio compatible UPnP/DLNA pour profiter d'Audio Station

Selon la gestion du streaming sur l'appareil cible, peut-être pas "toutes" les commandes. Par exemple si le récepteur est mon téléviseur ou mon Nest HUB, les fonctions volume, avance, retour et pause sont disponibles directement sur ce dernier (via la télécommande pour la TV et l'écran tactile pour le Nest).

-

Radio compatible UPnP/DLNA pour profiter d'Audio Station

DS Audio sur smartphone étant compatible Google Cast, n'est-ce pas une alternative viable en permettant un plus large choix de radio?

-

Mise en pause NAS

Pour commencer il faudrait essayer de trouver ce qui produit cette activité disque constante. Connecté sur DSM, lancer le moniteur de ressources, section gestionnaire de tache et trier la colonne lectures ou écritures et chercher qui est le coupable.

-

script pour effacer fichier automatiquement

Taper la commande sans le "-delete" dans une fenetre de terminal connecté SSH pour voir s'afficher les noms des fichiers qui sont éligibles à être effacés alors

-

script pour effacer fichier automatiquement

Pour supprimer des fichiers utiliser la clause "-delete", native, de find plutôt que ce "-exec" suivi d'un rm récursif (potentiellement dangereux en plus). Je préconise aussi "mtime" plutôt que "ctime". autre chose : le "mindepth" ne sert à rien ici Enfin (et surtout !) ce "test" en second paramètre est évidemment la cause de l'échec : ça recherche à partir du chemin spécifié en #1 un objet nommé "test" qui répond aux critères spécifiés pour y appliquer les actions qui suivent. Dans le meilleur des cas c'est ce fichier (ou dossier) "test" qui sera supprimé (s'il existe) mais rien de plus Et donc : find /volume1/dahua -type f -maxdepth 1 ! -user root -mtime +4 -delete -print devrait faire l'affaire

-

comment faire pour regarder des videos sur pc / android / tablette??

Sinon sans rien installer sur le NAS lui même, il existe des applications Android, compatibles Android TV qui savent streamer directement depuis le NAS (VLC, NOVA Video Player, et d'autres). A mon avis c'est sans doute le plus simple pour commencer.

-

Un test récent du RT6600ax

Publié hier : https://www.domo-blog.fr/test-synology-rt6600ax-wi-fi-6-mesh-tout-pour-reseau-maison-connectee/

-

Montée en gamme après DS213J

DS213j vers DS224+ c'est justement le parcours que j'ai suivi et ça me convient parfaitement (pour une utilisation un peu plus light toutefois)

-

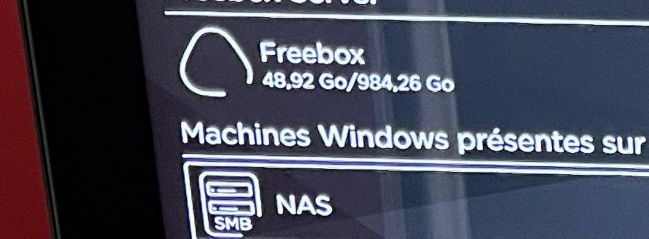

NAS SYNOLOGY // INTERFACE TV FREEBOX

Alors là, qu'un passage en IP fixe résolve un problème d'authentification échouée j'avoue que je n'étais pas prêt. [emoji54]

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Intéressant, en fait c'est le premier test qu'il aurait fallu faire. Je ne pourrai pas aider plus avant toutefois : je n'ai aucune expérience dans le monde Apple.

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Coté client SMB de la Freebox j'ai trouvé ceci qui pourrait être utile: https://www.perplexity.ai/search/quelle-version-de-smb-la-freeb-O1hr97P1Tn2X8w69c5Kx3g#0 Il semble y avoir une option à activer aussi sur la BOX Il seraut intéressant de vérifier que le NAS est accessible via l'explorateur de fichier de ton PC (ou MAC ?)

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Je m'aperçois qu'il y a une confusion vu que tu parles d'une "interface Freebox" sur la télé ce qui m'a induit en erreur. Mais c'est bien au NAS que tu cherches à accéder Par conséquent c'est un des comptes du NAS et son mot de passe associé qu'il faut saisir dans le formulaire du début.

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Alors il ne reste plus qu'à y choisir un nom et un mot de passe et ensuite saisir exactement les mêmes informations dans la fenêtre d'authentification que tu as postée dans ton premier message

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Tu parviens à atteindre le formulaire dont j'ai envoyé la copie d'écran déjà ?

-

NAS SYNOLOGY // INTERFACE TV FREEBOX

Il cherche juste à accéder aux répertoires partagés du NAS à partir de l'explorateur de fichiers intégré à sa télé, pas faire de partage d'écran. En outre suggérer de mettre en place un serveur Rustdesk à quelqu'un qui annonce "je n y connais rien du tout" ne me semble pas une si bonne idée que ça 😔