Classement

-

Mic13710

Les Modos51Points12224Compteur de contenus -

PiwiLAbruti

SynoCommunity45Points8767Compteur de contenus -

Lelolo

Les Modos21Points3649Compteur de contenus -

firlin

Membres19Points6729Compteur de contenus

Contenu populaire

Affichage du contenu avec la meilleure réputation depuis le 02/11/25 dans toutes les zones

-

Fichier Host Uploady.io

3 pointsBonjour, Quelqu'un aurait-il un lien pour télécharger un fichier host (download station) pour le site Updloady.io s'il vous plait ? Ou un tuto sur comment en créer un ? J'ai vu sur Google qu'il y avait un topic à ce sujet sur le forum mais je n'y ai pas accès : https://www.google.com/url?sa=t&source=web&rct=j&opi=89978449&url=https://www.nas-forum.com/forum/topic/81968-fichier-host-pour-uploadyio/%3Fdo%3DfindComment%26comment%3D1319513384&ved=2ahUKEwiKuK_mrpWLAxXZ3AIHHQ3lJ0gQFnoECAcQAQ&usg=AOvVaw1KQ-cOebOdNKcHwwUFaVT8 Merci d'avance3 points

-

[TUTO] [Docker - macvlan] Pi-Hole (V6)

Refonte du tutoriel pour la V6, amélioration du fichier compose et mise à jour des impressions d'écran.3 points

-

[TUTO] [Pas-à-pas] Sécurisation du NAS - pour DSM 7

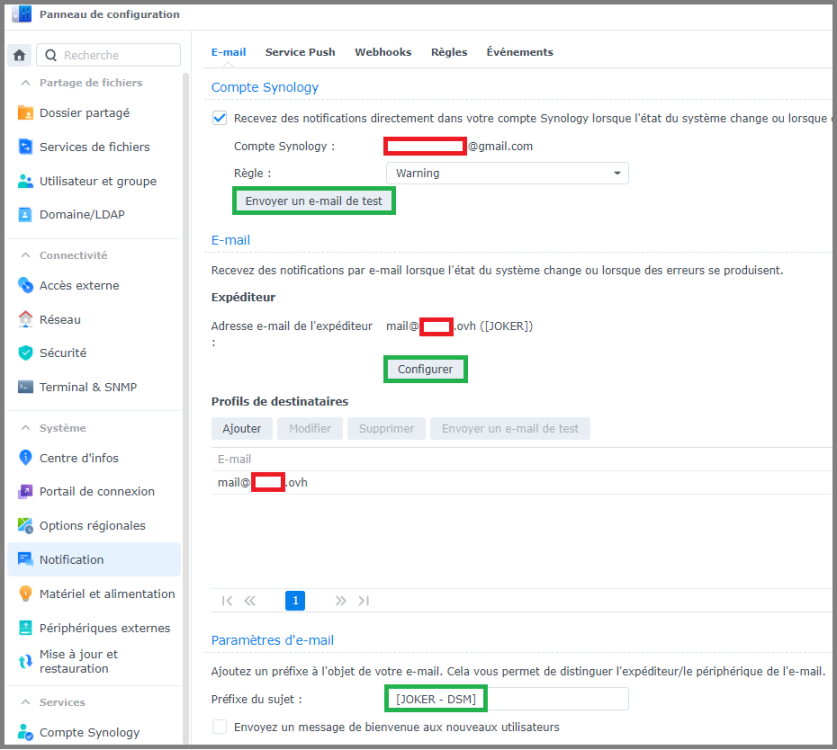

Pour qui ? Depuis plusieurs années, ce tutoriel rédigé par @Fenrir est LA référence en matière de sécurisation des accès à un NAS. C'est de loin le tutoriel le plus lu du forum, et c'est une bonne chose, car cela signifie que les utilisateurs de NAS Synology se préoccupent de sécuriser leurs données. Néanmoins, bien que le tutoriel soit toujours d'actualité, certaines sections de DSM sont organisées différemment depuis l'arrivée de DSM 7. En outre, certaines informations importantes se trouvent dans les innombrables pages de commentaires, ce qui ne facilite pas la tâche aux nouveaux venus. A l'usage, on remarque également qu'il peut : parfois aller trop vite sur certains points pour des néophytes être a contrario trop succinct pour des utilisateurs souhaitant aller plus loin dans la sécurisation des accès. Il a donc été convenu de rédiger deux versions du tutoriel : cette version, une version plus pas-à-pas, reprenant l'essentiel du tutoriel original, destinée à permettre une rapide mise en service d'un NAS de manière sécurisée. C'est l'objet du tutoriel que vous allez maintenant suivre. une version plus avancée, pour utilisateurs avertis Le tutoriel s'inspire grandement du tutoriel original, merci encore à @Fenrir son rédacteur. Préambule et recommandations Définition Mais commençons par un peu de vocabulaire, un produit labélisé NAS chez Synology est en réalité un serveur, disposant d'un OS, d'un processeur et de mémoire, permettant : La mise à disposition en réseau de données par de nombreux protocoles : HTTP, HTTPS, CIFS, NFS, SSH, etc... L'hébergement de services divers et variés : nativement (Centre de paquets) par conteneurisation (Container Manager) (plus d'info ici) par virtualisation (Virtual Machine Manager) Dans la suite du tutoriel, nous emploierons improprement le terme NAS par commodité. Cahier des charges Ce que ce tutoriel couvre : La configuration des protocoles utilisés pour les accès au NAS La configuration du pare-feu La mise en place d'un certificat TLS La configuration d'un service de notification La protection des accès utilisateurs La configuration des cartes réseau Ce que ce tutoriel ne couvre pas : La configuration de votre box pour un accès distant La mise en place d'un proxy inversé La mise en place d'un serveur VPN Le chiffrement de volume ou de dossier partagé La sauvegarde et la restauration de données (outre la configuration du système) // IMPORTANT \\ En appliquant ce tutoriel, vous coupez votre NAS de tout accès extérieur. Pour accéder à votre NAS à distance, il existe plusieurs méthodes : Utilisation du relais QuickConnect de Synology, point abordé dans la partie Accès externe. Accès par nom de domaine (point abordé dans la partie Accès externe également) + redirection de ports (avec ou sans proxy inversé) Utilisation d'un serveur VPN sur le NAS pour le transfert de fichiers uniquement : FTP, SFTP, WebDAV, etc... Veuillez vous référez aux liens fournis pour la mise en place d'un accès externe sécurisé. Prérequis et méthode Le vocabulaire dédié au monde du réseau est spécifique, il est conseillé de lire le sujet rédigé par @Kramlech, ces notions seront utiles pour la compréhension de la suite du tutoriel. De plus, ce tutoriel renverra vers d'autres tutoriels pour ceux qui souhaitent aller plus loin. Si une catégorie ou un onglet ne sont pas mentionnés, c'est qu'ils ne présentent pas d'intérêt dans le cadre de ce tutoriel. Lorsque des explications supplémentaires mais non nécessaires sont proposées, elles sont cachées dans des balises spoiler : Lisez ce tutoriel en diagonale une première fois pour avoir une vision globale des modifications que vous vous apprêtez à effectuer La plupart des fenêtres que vous ouvrirez dans DSM possède une aide intégrée, celle-ci est généralement bien documentée et traduite, cela vous permettra de connaître plus en détail les fonctionnalités offertes par les divers champs activables : Précautions Sauvegarde de la configuration Que vous veniez d'installer DSM sur votre NAS, ou que vous ayez déjà une instance de DSM en production, il est impératif de réaliser une sauvegarde de la configuration avant de commencer, pour cela, on va dans Démarrer -> Panneau de configuration -> Mise à jour et restauration -> Sauvegarde de configuration -> Exportation manuelle : Cliquez sur Exporter et sauvegarder le fichier sur votre ordinateur. En cas de problème, il sera possible de restaurer la configuration précédemment exportée en cliquant sur Restauration. J'ai tout cassé Si vous n'arrivez plus à avoir accès à votre NAS suite à un réglage effectué au cours du tutoriel, vous pouvez toujours effectuer un reset mode 1 du NAS. Celui-ci est suffisant dans l'extrême majorité des cas, et il a l'avantage de réinitialiser un nombre limité de réglages qui sont susceptibles de provoquer une perte d'accès à DSM. _________________________________________________________________________________________________________________________________________________________________________________________ Sécurité Cette section sera abordée plus en détail par après, mais dans un premier temps il est impératif de sécuriser les accès à votre NAS. Pare-feu - Accès locaux Par défaut, le pare-feu n'est pas activé, et donc tous les accès sont permis. L'idée générale est d'autoriser les accès depuis le réseau local, et de le fermer aux accès distants. Au fil des années, nous avons pu constater que la pratique habituelle de créer des règles pour toutes les interfaces pouvaient avoir des effets de bord indésirables, notamment dans le cadre de l'utilisation d'un serveur VPN, il est donc plus sécurisé de créer le minimum de règles pour chaque interface séparément. Et c'est la méthode que nous allons détailler. Pour configurer le pare-feu, il faut cocher Activer le pare-feu. Il est conseillé de laisser les notifications du pare-feu tout en les refusant quand elles apparaitront à l'installation de paquets, afin d'être informé des ports utilisés par les dits paquets. On va ensuite cliquer dans la liste déroulante contenant les profils de pare-feu, et cliquer sur Gérer le profil du pare-feu. On va cliquer sur Créer pour créer un nouveau profil, et on le nomme par-interface : On sélectionne l'interface qu'on souhaite configurer, ici pour l'exemple LAN 1. On va tout d'abord ajouter quatre règles garantissant un accès local complet à votre NAS : Pour ce faire, on procède ainsi : On clique sur Créer On coche IP spécifique puis on clique sur Sélectionnez On choisit Sous-réseau et on entre 192.168.0.0 dans Adresse IP, et 255.255.0.0 dans Masque de sous-réseau ATTENTION : si vous le souhaitez, vous pouvez restreindre à votre réseau local. Ici on couvre toute la plage locale possible en 192.168. Par exemple, si le réseau de votre box est 192.168.1.x, alors vous pouvez entrer 192.168.1.0/255.255.255.0 On valide : On répète la même opération pour les deux autres règles, 172.16.0.0/255.240.0.0 et 10.0.0.0/255.0.0.0 On ajoute une règle pour les accès locaux en IPv6 : A elles quatre, ces règles permettent à tous les clients utilisant des IP privées d'accéder à tous les services du NAS (attention, ils sont toujours toutefois soumis aux processus d'authentification, ces règles leur permettent uniquement de ne pas faire se refouler à l'entrée). Dernier point, mais le plus important, on choisit Refuser l'accès comme comportement du pare-feu en cas de requête non déclenchée par les règles précédemment ajoutées : _________________________________________________________________________________________________________________________________________________________________________________________ Notifications Celles-ci sont requise pour certaines fonctionnalités comme l'authentification à deux facteurs ou plus simplement pour que vous soyez prévenu dès qu'un problème survient dans le système. On va dans Panneau de configuration -> Notification : Dans Compte Synology, cochez Recevez des notifications directement dans votre compte Synology lorsque l'état du système change ou lorsque des erreurs se produisent En activant l'option, vous serez invité à vous connecter à votre compte Synology. Cela nécessite la création ou l'association à un compte Synology Dans Email, on clique sur Configurer, et on choisit un fournisseur SMTP ou on configure le sien si on en a un Dans Profils de destinataires, on peut choisir des adresses mail différentes suivant la criticité des événements. On clique sur Ajouter. On utilise la règle Warning et on entre l'email de destination, il peut être le même que l'expéditeur Dans Paramètres d'email, on peut personnaliser le préfixe de l'objet du mail On clique sur Envoyer un e-mail de test dans Profils de destinataires pour vérifier que tout fonctionne. Vérifier votre boîte de spam si rien n'arrive _________________________________________________________________________________________________________________________________________________________________________________________ Services de fichiers On va dans Panneau de configuration -> Services de fichiers SMB Général SMB (ou Samba dans sa déclinaison Linux) est le protocole utilisé par Windows lorsqu'on monte un lecteur réseau dans l'explorateur de fichiers. Mais même sous Linux, il est le protocole à privilégier lorsqu'on se connecte à un NAS. Dans Paramètres SMB, cochez Activez le journal des transferts On coche Masquer les dossiers partagés pour les utilisateurs ne disposant pas d'autorisation Dans WS-Discovery, on coche Activer la découverte de réseau Windows pour autoriser l'accès aux fichiers via SMB : On clique sur Paramères avancés et on définit le protocole SMB minimum sur SMB2 et Large MTU, SMB1 a de nombreuses failles de sécurité et n'est plus nativement par défaut activé dans DSM : Autres On coche les 3 options suivantes : Si on souhaite activer SMB3 multicanal, on doit cocher Activer SMB3 multicanal et Activer la lecture asynchrone, le service est ensuite redémarré. AFP, NFS, FTP, rsync et Avancés N'activez que les protocoles et options dont vous avez besoin, autrement laissez les réglages par défaut. _________________________________________________________________________________________________________________________________________________________________________________________ Utilisateur et groupe Utilisateur / Groupe Ce tutoriel n'aborde pas dans le détail la gestion des groupes et utilisateurs, gardez toutefois à l'esprit que : Rationalisez les permissions. Dans le cas d'utilisateurs similaires, créer un groupe reprenant les permissions partagées est plus élégant que de configurer manuellement les droits de chaque utilisateur Limitez les permissions d'un utilisateur ou un groupe au strict nécessaire Compte administrateur alternatif Lors du passage à DSM 7, ou lors d'une nouvelle installation, vous êtes invités à créer un nouveau compte administrateur si votre seul compte administrateur est le compte "admin". Cela permet d'avoir un compte administrateur avec des accès plus robustes (voir Politique de mot de passe), et de désactiver le compte "admin" par défaut, sur lequel vous ne pourrez plus vous connecter. /!\ CETTE ÉTAPE EST OBLIGATOIRE /!\ Configuration du mot de passe On se dirige vers l'onglet Avancé -> Configuration du mot de passe : Espace personnel de l'utilisateur Au bas du menu Avancé on coche Activer le service d'accueil de l'utilisateur, afin que chaque utilisateur dispose de son propre dossier personnel dans homes (homes n'est visible que des membres du groupe administrateurs). ATTENTION : Il est primordial de ne pas toucher aux permissions du dossier homes (visible uniquement par les administrateurs) et aux dossiers home (pour les utilisateurs non administrateurs). _________________________________________________________________________________________________________________________________________________________________________________________ Accès externe QuickConnect Si vous ne souhaitez pas accéder à votre NAS en dehors de votre domicile, désactivez Quickconnect. DDNS Si vous ne souhaitez pas accéder à votre NAS en dehors de votre domicile, vous pouvez ignorer ce passage. Configuration du routeur Ne cliquez pas ici, ça fait partie des options que Synology devrait vraiment retirer de ses boitiers. C'est très dangereux du point de vue sécurité. Ça sert à ouvrir automatiquement des ports dans votre routeur/box, ça peut paraitre sympa comme ça mais en pratique c'est une faille de sécurité très importante. Deux exemples pour essayer de vous convaincre : pour que cette fonction marche, votre routeur doit gérer l'UPnP, donc tous les équipements de votre réseau pourront faire de l'ouverture dynamique de port, le PC qui vient d'être vérolé pourra automatiquement, sans la moindre notification, ouvrir un port permettant à un attaquant d'entrer dans votre réseau de même, si vous avez configuré des redirections de ports pour plusieurs équipements, ces redirections risquent de sauter si une requête UPnP demande le même port Avancé Un onglet que beaucoup oublient de configurer, il n'est pas obligatoire et pas lié (pas directement du moins) à la sécurité mais ça permet d'éviter de chercher des heures la raison pour laquelle un lien de partage (par exemple) ne fonctionne pas : REMARQUE : si vous utilisez le proxy inversé ou le portail des applications de DSM, il n'est pas utilie de configurer ce menu. _________________________________________________________________________________________________________________________________________________________________________________________ Réseau L'onglet Réseau dans le panneau de configuration permet de régler la connectivité de votre appareil et ses interfaces. Interface réseau IPv4 Dans l'onglet Interface réseau, on sélectionne l'interface qu'on souhaite configurer et on clique sur Modifier : Pour obtenir une IP, deux méthodes existent : Le NAS acquiert son IP grâce au serveur DHCP, généralement votre box ou votre routeur. Pour s'assurer que cette IP ne change pas d'une fois à l'autre, il faut faire ce qu'on appelle une réservation statique d'IP dans votre serveur DHCP. Concrètement, cela signifie que pour une adresse MAC donnée (le numéro d'identité de votre carte réseau en quelque sorte), le serveur DHCP attribuera toujours la même adresse IP. On fixe l'IP du NAS directement sur celui-ci, pour cela on choisit Utiliser la configuration manuelle et on choisit une IP. ATTENTION : il faut que l'IP choisie : soit dans la plage IP de votre réseau local soit hors de la plage DHCP d'attribution de votre box/modem. La première méthode a l'avantage qu'en cas de : changement de box de modification de sous-réseau (passer de 192.168.1.0 à 192.168.10.0 par exemple) de déménagement Le NAS restera accessible car il obtiendra une IP dans tous les cas avec un nouveau modem, il ne vous restera plus qu'à le trouver via Synology Assistant. IPv6 A l'heure actuelle, l'IPv6 est bien plus prise en charge par les FAI qu'au temps de la rédaction du tutoriel original, certains mêmes ne proposent plus que de l'IPv6 nativement. Si vous souhaitez l'activer, choisissez Auto : Général Dans l'onglet Général de la catégorie Réseau : Dans Paramètres avancés : Cochez Répondre à la demande ARP si l'adresse IP cible est identique à une adresse locale configurée sur l'interface entrante, cela permet de faire en sorte que les données sortent par leurs interfaces respectives. Cochez Activer la détection des conflits IP, vous aurez des notifications dans DSM si votre NAS rencontre des problèmes de conflit d'IP. Connectivité Cochez Activer HTTP/2 _________________________________________________________________________________________________________________________________________________________________________________________ Sécurité A n'en pas douter la catégorie la plus importante de ce tutoriel ! Le pare-feu a été configuré pour un accès local en tout début de tutoriel. Général Vous pouvez laisser les réglages par défaut Compte Authentification à deux facteurs (2FA) L'authentification à deux facteurs apporte une couche de sécurité supplémentaire, mais elle n'est en aucun cas un remède palliatif à des accès utilisateurs trop faibles. L'authentification à deux facteurs est également plus contraignante en cas de perte du périphérique sur lequel elle est configurée, s'il s'avérait être le seul. Un code de récupération est fourni par DSM pour y retrouver accès, il est impératif de le noter. Si vous souhaitez activer l'authentification à deux facteurs, suivez les étapes suivantes : Adaptive MFA Cochez Activer l'authentification multifacteur adaptative pour les utilisateurs appartenant au groupe administrateurs (pour version de DSM > 7.2) Protection du compte Cochez Activez la protection du compte : Ajuster les valeurs proposées par défaut à votre convenance. Pare-feu - Accès distant Cette section est restreinte au minimum, car le but est ici de sécuriser les accès à votre NAS. A partir du moment où le NAS est accessible depuis l'extérieur, sa surface d'exposition est bien plus importante. Mais vu que nous allons voir comment obtenir un certificat pour votre NAS, il paraît naturel d'évoquer la mise en place d'un accès distant sur celui-ci, pour en savoir plus, c'est par ici : Protection Cochez Activer le blocage auto, ainsi que Activer l'expiration des blocages avec les réglages suivants : Cliquez ensuite sur Autoriser/Bloquer la liste, sélectionnez Créer -> Ajouter une adresse IP, choisissez Sous-réseau et ajouter les deux entrées suivantes : REMARQUE : Si vous avez mis un sous-réseau et masque plus restrictifs que 192.168.0.0/255.255.0.0 dans vos règles de pare-feu, par exemple pour vous conformer au réseau utilisé par votre box, supposons 192.168.1.0/255.255.255.0, vous pouvez dans ce cas spécifier 192.168.1.0/24 dans le menu ci-dessus. Enfin, cochez également Activer la protection DoS. Certificat La mise en place d'un certificat est utile pour : établir un accès distant sécurisé (chiffré) vers votre NAS la mise en place d'un serveur DNS local la mise en place d'un proxy inversé Si les uns et les autres ne vous sont d'aucune utilité, passez à la section suivante. Avancé Dans cet onglet, nous allons régler le niveau de sécurité de chiffrement des services systèmes : La compatibilité moderne correspond à TLS 1.3 qui est maintenant assez répandu, si vous avez des smartphones relativement récents vous ne devriez pas rencontrer de problème. La compatibilité intermédiaire prend en charge TLS 1.3 et 1.2, c'est le choix qui couvrira le plus de périphériques. Depuis la version 7.1 de DSM, il est possible via le menu Paramètres personnalisés de définir séparément le niveau de sécurité utilisé par les applications. _________________________________________________________________________________________________________________________________________________________________________________________ Terminal & SNMP Avancé Je recommande de cocher Activer le service SSH, cela vous donne une porte de secours en cas de problème d'accès à DSM. Si vous deviez rendre accessible le terminal de votre NAS depuis l'extérieur, je recommande très fortement de ne pas faire une simple redirection de port au niveau de votre box mais d'utiliser un serveur VPN, par exemple via le paquet VPN Server. _________________________________________________________________________________________________________________________________________________________________________________________ Portail de connexion DSM Vous pouvez cocher la case Rediriger automatiquement les connexions HTTP vers HTTPS pour le bureau DSM pour vous connecter automatiquement en HTTPS même si l'adresse entrée commence par HTTP. Il est préférable d'avoir mis en place un certificat avant d'activer cette option pour éviter les avertissements de sécurité du navigateur. REMARQUE : Ne pas activer cette option si vous utiliser un proxy inversé pour accéder à vos services DSM. _________________________________________________________________________________________________________________________________________________________________________________________ Options régionales Pour que l'authentification à deux facteurs fonctionne correctement, il est important que vos périphériques soient synchronisés temporellement. Assurez-vous de régler la synchronisation temporelle du NAS sur une source sure, dans Temps puis Paramètres de l'heure, cochez Synchroniser avec un serveur NTP et entrez manuellement l'adresse fr.pool.ntp.org par exemple si vous résidez en France, ou ntp.fdn.org. La liste complète des serveurs NTP peut se trouver à l'adresse suivante : https://www.ntppool.org/zone/@ _________________________________________________________________________________________________________________________________________________________________________________________ Mise à jour et restauration Mise à jour du DSM On clique sur Options de mise à jour, puis on choisit M'avertir et me laisser décider d'installer la nouvelle mise à jour : Synology est coutumière de déploiements erratiques de ses mises à jour, donc suivez ces quelques conseils : Prenez le temps de lire les notes de patch lors de la sortie d'une nouvelle version de l'OS, il se peut qu'elle n'apporte rien dans votre utilisation du NAS N'appliquez de préférence une mise à jour que si elle est proposée automatiquement par le système (évitez les mises à jour manuelles) Sauf correctifs de sécurité importants, ne vous précipitez pas pour appliquer une mise à jour, laissez le temps aux développeurs et aux autre utilisateurs le soin de se casser les dents dessus, il y en a suffisamment sur le forum. 😉 Sauvegarde de configuration Si vous avez lié votre compte Synology à votre NAS, par le biais de la configuration du DDNS ou via la section Compte Synology dans le panneau de configuration, vous avez la possibilité d'enregistrer automatiquement la configuration de votre NAS dans votre espace client Synology. C'est une option intéressante et je recommande de l'activer : IMPORTANT : Avoir une sauvegarde automatique de la configuration dans le cloud ne dispense pas de disposer d'une version locale de celle-ci. En cas de changement notable dans votre configuration, pensez à faire une Exportation manuelle de la configuration, et à la copier sur un ou plusieurs périphériques : PC, clé USB, disque externe, etc... _________________________________________________________________________________________________________________________________________________________________________________________ Privilèges d'application Pas de recommandation spécifique à ce sujet, vous pouvez décider de restreindre les privilèges accordés par défaut à TOUS les utilisateurs dans cette catégorie, ou bien laisser les autorisations et restreindre au niveau de permissions de groupe et d'utilisateur. A titre personnel, je trouve plus simple de régler de façon granulaire les accès des groupes et utilisateurs dans la catégorie Utilisateur et groupe. _________________________________________________________________________________________________________________________________________________________________________________________ MAJ : 07/11/20232 points

-

[firmware migration] Installation du firmware Qnap (QTS) sur NAS Fujitsu Celvin via SSH

Installation du firmware Qnap (QTS) sur NAS Fujitsu Celvin via SSH Rappel: La majorité des serveurs NAS Fujitsu Celvin sont fabriqués par QNAP (Produits OEM ou Co-branding) ce qui signifie que les modèles Fujitsu sont des versions reconditionnées de modèles QNAP, avec un design légèrement modifié (logo, couleur) et un firmware spécifique. Le firmware de Fujitsu (Celvin OS) est très proche de celui de Qnap (QTS). Fujitsu assure la totalité des services comme pour tous produits Fujitsu: Support client, mise à disposition de mises à jours et d'applications qui lui sont propres, même si elles sont identiques à celles du Qnap. Parfois Fujitsu ne fait que changer le nom de l'application. Fujitsu dispose de ses propres serveurs pour les mises à jours et pour "app center". Pourquoi migrer de Fujitsu à Qnap? Fujitsu a cessé le support des NAS CELVIN. Par exemple les NAS sortis entre 2009 et 2012 ne sont plus pris en charge par Fujitsu depuis 2018. En 2025, Fujitsu a arrêté le serveur d'app center, Plus aucune application n’apparaît dans le magasin d'applications. La seule manière d'installer des applications est l'installation manuelle. En 2020 Fujitsu et Qnap ont décidé que Qnap poursuive le support pour les NAS concernés. Une fois le NAS migré, il est pris en charge par Qnap et bénéfice de tous les services et supports de Qnap. La migration permet de bénéficier des mises à jours de sécurité du firmware Qnap. Elle permet de retrouver un app center fonctionnel et permet d'installer les anciennes applications qui y sont proposées. Même chez Qnap, pour le vieux matériel certaines applications ne bénéficient plus de mise à jours, ce qui limite de l'utilisation des applications officielles. Mais beaucoup d'applications non officielles sont disponibles en paquets (qpkg), notamment sur le site myqnap.org. L'intérêt de la migration est essentiellement d'obtenir les mises à jours de sécurité de QTS. Pour bénéficier d'applications récentes, l’utilisation d'applications tiers est la meilleurs solution. Comment migrer? En accord avec Qnap, Fujitsu propose pour certains modèles une méthode automatisée par l'installation d'un paquet officiel (qpkg) qui permet d'installer le firmware QNAP (QTS) à la place de celui de Fujitsu par l'interface de gestion du NAS comme si on faisait une simple mise à jour. Le paquet modifie tout simplement le nom du modèle du NAS pour que la mise à jour vers le firmware équivalent de chez Qnap fonctionne Les modèles concernés sont les suivants:Q805, Q905, QR806, QR1006, QE705, QE805, QE707, QE807. L'autre moyen de migrer est d'utiliser la méthode manuelle par SSH présentée ici. Pour les modèles qui ne bénéficient pas de la méthode automatique, SSH est la seule méthode possible. Migration manuelle par SSH: Prérequis: Avoir un NAS fonctionnel: Avec au moins un disque dur configuré dans le NAS, qu'il soit accessible depuis votre PC avec l'interface de gestion Web et avec accès aux dossiers partagés depuis votre PC. A savoir: Les systèmes d'exploitation des NAS Qnap (et Fujitsu), sont basés sur un noyaux Linux. Vous y retrouverez donc des programmes et structures similaires. Il est même possible d'installer une distribution Linux comme Debian sur le NAS. La méthode SSH utilise une procédure d'installation manuelle du firmware fournie par Qnap. Elle est réservée aux utilisateurs avertis, car elle permet d'installer un firmware dont le nom de modèle ne correspond pas à celui installé sur le NAS. Il faut être sûr d'avoir le firmware du modèle Qnap correspondant à votre NAS Fujitsu. Si vous installez le mauvais firmware, vous pouvez rendre votre NAS inutilisable! Vérifiez bien sur le site de Qnap si les caractéristiques sont les mêmes que votre modèle Fujitsu. Après installation, le nom de modèle de votre NAS sera celui de Qnap, il sera reconnu comme tel par Qnap et app center proposera les applications compatibles avec votre modèle. Vous trouverez des ressources (Aides - How to) en français sur le site de QNAP https://www.qnap.com/fr-fr/how-to/search Il existe un wiki plus complet en anglais https://wiki.qnap.com/wiki/Main_Page Procédure: Télécharger le firmware QNAP correspondant à votre modèle. Le firmware se présente comme une image de disque (.img) qui est compressée au format zip (.zip): Allez dans le Centre de téléchargement QNAP: https://www.qnap.com/fr-fr/download Sous "Type de produit", sélectionnez "NAS / Extension". Sous "Baie", sélectionnez le nombre de baies de lecteur pour votre NAS. Sous "Modèle", sélectionnez le nom du modèle Qnap correspondant à votre NAS Fujitsu. Dans la section "Télécharger les éléments", cliquez sur "Système d’exploitation". La liste qui apparait est celle du firmware (Système d'exploitation) avec le plus récent en haut. Téléchargez le fichier en cliquant sur le lien dans la colonne "Lien de téléchargement". Décompressez le fichier zip. Copiez le firmware dans le dossier Public du NAS: Vous pouvez renommer le ficher image (.img) que vous venez de décompresser. J'ai effectué la migration d'un Q703. Je prends donc ce modèle comme exemple. J'ai renommé le ficher image en "TS-221.img". Remplacer "TS-221.img" par le nom que vous avez choisi dans le reste du tutoriel. Par l'explorateur de fichiers de votre système, copiez le fichier image dans le dossier Public du NAS. Autoriser la connexion SSH dans le NAS: SSH, pour Secure Shell, est un protocole de communication réseau qui permet d’établir une session chiffrée entre deux machines, typiquement un client et un serveur. Si la connexion au NAS par SSH n'est pas activée, vous devez l'activer soit par l'interface du NAS, soit avec Qfinder. Si besoin aller voir l'aide QNAP: https://www.qnap.com/fr-fr/how-to/faq/article/comment-acc%C3%A9der-%C3%A0-mon-nas-qnap-en-utilisant-ssh Accédez à votre NAS avec SSH: Vous devez ouvrir une console (un terminal) prenant en charge SSH. Sous MacOS et Linux, cette fonctionnalité est généralement activée par défaut. Sous Windows, elle n'est pas toujours disponible. Sous Windows 10 ou 11, Vous devez activer le "client OpenSSH" dans les paramètres de Windows. Si vous ne savez pas comment faire, vous trouverez des tutos sur internet. Une fois fait, les consoles de Windows prendrons en charge SSH. Il vous suffit alors d'ouvrir une console, soit par l’invite de commandes Windows (CMD), soit par PowerShell. Sinon, vous pouvez installer un programme comme "Git Bash" ou "PuTTY". La page d'aide indiqué précédemment montre la méthode pour MacOS et pour Windows avec "PuTTY". Installer le firmware avec l'image: Dans la console que vous venez d'ouvrir, saisissez les commandes suivantes et terminez par la touche "Enrtée" pour validez (exécutez) les commandes. Vous pouvez les copier-coller. N'oubliez pas d'adapter les valeurs à votre cas (adresse IP du NAS, nom de l'image). Code: ssh Code: ssh admin@ipRemplacez « ip » par l'adresse IP de votre NAS. Le système vous demande ensuite le mot de passe. Celui par défaut est « admin ». [Par cette commande, vous vous connectez au NAS à distance en vous identifiant comme l'utilisateur "admin", comme vous le faites lorsque vous accédez à l'interface de gestion du NAS avec votre navigateur, mais ici vous le faites en ligne de commande par le protocole SSH.] Saisissez ensuite les commandes suivantes: Code: mkdir /mnt/HDA_ROOT/update[Cette commande créé le répertoire "update" dans le répertoire HDA_ROOT.] Code: rm -rf /mnt/update[Cette commande efface le contenu du répertoire "update" au cas où il ne soit pas vide.] Code: rm -f /tmp/update_process[Cette commande efface un éventuel fichier temporaire qui serait resté d'une précédente mise à jour] Code: ln -sf /mnt/HDA_ROOT/update /mnt/update[Cette commande créé un lien symbolique entre les deux emplacements.] Code: /etc/init.d/update.sh /share/Public/TS-221.img[Cette commande lance le "script" (ou programme) d'installation du firmware (update.sh) et lui indique ne nom de l'image ("TS-221.img" dans mon cas) et son emplacement (dossier Public du NAS).] Le processus d'installation se déroule et des informations apparaissent dans le terminal tout au long du processus. Le processus peut prendre un certain temps. Vous verrez apparaitre le nom du modèle d'origine du NAS, Q703 dans mon cas : "model name = Q703". Une ligne plus bas vous indiquera le nouveau nom de modèle qui sera attribué au NAS: TS-221 dans mon cas. Si tout se déroule correctement, la procédure se termine par le message : « Mise à jour terminée ». Saisissez ensuite : Code: rebootAprès le redémarrage, qui est assez long, vous trouverez la nouvelle interface sous QTS en vous connectant au NAS avec votre navigateur ! Dans mon cas, tout était intact : mes applications et mes données étaient toujours présentes. [Pour information, après la migration j'ai voulu faire une réinitialisation sans formatage des disques, Mais lors du redémarrage, le système m'a forcé à réinstaller le firmware. Il suffit de sélectionner le fichier image (TS-221.img dans mon cas) et de laisser le processus se faire.] Il est alors possible de créer un compte sur le site de QNAP, d'enregistrer le NAS et d'utiliser tous les services QNAP. N'hésitez pas à partager vos expériences de migration de votre NAS ou à les publier sur le forum! Je suppose que cette méthode fonctionne avec tous les modèles QNAP, car la documentation QNAP ne mentionne aucun modèle particulier. - Page de l'aide du site QNAP pour la mise à jour par SSH: Comment mettre à jour manuellement le firmware par SSH ? - Page du site Wiki QNAP pour la mise à jour par SSH: : Manually Updating Firmware Au cas où votre NAS ne démarre plus: Récupérer un NAS ARM ancienne génération Récupérer un NAS X86 ancienne génération2 points

-

DS218+ et DSM 7.3.2

2 pointsIl n'y a plus de mise à jour automatique des versions mineures de DSM pour les modèles des séries ´16 à ´19 depuis DSM 7.2. Elles ne peuvent donc être faites que manuellement.2 points

-

[Résolu]Après installation 7.3, la synchro Active Directory ne fonctionne plus correctement sur les groupes d'utilisateurs

merci pour la réponse. C'est fait et nous avons eu la réponse. Effectivement il s'agit d'un bug sur la 7.3 (depuis la 1ere version). Un correctif est prévu (quand ?). En attendant pour résoudre le problème nous avons découvert qu'il ne fallait pas utiliser la planification de synchronisation de l'AD sur le NAS. C'est ce que nous a confirmé Syno. Dommage que ce genre de bug majeur ne soit listé quelque part, avec le contournement possible. Cela éviterait 2 jours de travail avant de comprendre et de trouver nous-mêmes la solution.2 points

-

DSM 7.3 en vue

2 pointsBonjour, Je viens de voir que dsm 7.3 est en vue. Ce sera la dernière mise à jour pour mon DS 218+ 😞2 points

-

Plusieurs nas derière une seule IP publique pour synology drive

Autre solution : en IPv6, chaque NAS a sa propre adresse IP publique, et est donc adressable sans souci, sur tous les ports.2 points

-

[TUTO] [Docker - macvlan] Pi-Hole (V6)

Salut @.Shad., Le problème avec les serveurs DNS c'est que leur hiérarchie n'est pas respectée. Le client peut faire appel à n'importe quel serveur de la liste. Si le DHCP distribue plusieurs IP DNS, il vaut mieux que ces serveurs résolvent les requêtes de la même manière. Je suis plutôt pour une deuxième instance pi-hole (ce que j'ai), ou bien à la limite passer par le serveur DNS du NAS avec une zone correctement paramétrée. Surtout pas d'autres serveurs externes qui sont incapables de résoudre les adresses locales.2 points

-

[TUTO] [Docker - macvlan] Pi-Hole (V6)

Hello, j'ai aussi fait la migration il y a quelques semaines et ça s'est très bien passé. Je vais essayer de trouver le temps de mettre à jour le tutoriel, je devrais retrouver des disponibilités à partir de fin juin...2 points

-

SSH repertoire

2 points

-

Domotique et Synology

2 pointsIl y a aussi Domoticz que j'utilise sur un Rasp PI4. A mon avis, que ce soit home assistant, jeedom ou domoticz ou d'autres, mieux vaut ne pas solliciter le NAS pour ces applications qui sont en général nativement adaptées et parfaitement intégrées sur des plateformes type Rasp.2 points

-

WOL de mon NAS

2 pointsPar défaut, un paquet WoL n'est diffusé que sur le segment réseau de l'émetteur. Dans le cas présent, le smartphone n'émet ce paquet que sur le réseau 192.168.68.0/24 (broadcast à destination de 192.168.68.255 ou 255.255.255.255). Le paquet ne peut donc pas parvenir au NAS situé sur un autre segment (192.168.1.0/24). Il est très peu probable que le routeur Mesh propose un proxy WoL pour propager la diffusion du paquet sur les autres segments qui y sont connectés. La solution la plus simple est de connecter le NAS derrière le routeur mesh (attention au changement d'adressage IP). La solution la plus propre est de configurer un unique segment réseau en configurant les appareils réseau du réseau mesh en points d'accès Wi-Fi.2 points

-

Nouveau sur le forum – besoin de conseils pour premier NAS Synology

Bonjour, Je n'ai pas tout compris...2 points

-

problème synology drive client sur linux mint 22

Re-bonjour, J'ai trouvé ma réponse : mon mot de passe contient des caractères spéciaux dont la saisie est mal interprétée dans drive client ubuntu. En saisissant le mot de passe dans un éditeur quelconque, puis en le copiant dans le mot de passe de la connexion drive client, Ö miracle, ca fonctionne. bien à vous2 points

-

Soucis sur les Atom C2000, Panne Programmée des modèles RS2416+ / RS2416RP+, RS815+/RS815RP+, DS2415+, DS1815+, DS1515+, DS415+.

Attention toutefois, dans le tuto donné par @firlin, la résistance est à 100ohm. Il faut remplacer cette valeur par 300ohm environ pour limiter le courant dans le transistor (voir ce fil de discussion)2 points

-

SOS

2 points@Sun880 Tu es mal placé pour faire le malin... De plus tu as posté dans une autre rubrique la même question à 2 reprises. Je te laisse une semaine de vacances pour t'approprier le fonctionnement du forum2 points

-

Témoignage : de l'importance de sécuriser son NAS

Bonjour, Dès que j'ai installé mon NAS DS418j en 2018, j'ai suivi le tuto de Fenrir sur la sécurisation puis plus tard celui de .Shad. quand je suis passé à DSM7. Et bien m'en a pris ! Je n'ai rien remarqué d'anormal pendant quelques années jusqu'en 2023, année où des tentatives d'accès ftp "anonymous" non souhaitées ont été détectées. A noter que j'ai banni "anonymous" dès le début sur mon NAS ! Sans parler d'attaque massive, loin de là, j'ai maintenant régulièrement des tentatives d'accès signalées par un message comme celui d'hier qui me dit : Le contenu du journal est le suivant : User [anonymous] from [137.74.181.248] failed to log in via [FTP] due to authorization failure. J'ai relevé toutes ces tentatives avec leurs références et voici ce que ça donne : Adresse IP Date Localisation Fournisseur 92.154.95.236 15/04/2023 Paris (75) F.T.Orange 92.151.80.83 30/08/2023 Colombes (92) F.T.Orange 80.13.153.140 06/09/2023 Paris (75) F.T.Orange 79.137.7.75 15/12/2024 Roubaix (59) OVH SAS 51.91.174.243 23/12/2024 Roubaix (59) OVH SAS 5.196.113.1 29/12/2024 Roubaix (59) OVH SAS 178.32.170.18 04/01/2025 Gravelines (59) OVH SAS 51.91.174.240 11/01/2025 Roubaix (59) OVH SAS 149.202.132.194 20/01/2025 Saint-Grégoire (35) OVH SAS 5.135.58.198 24/01/2025 Saint-Grégoire (35) OVH SAS 54.38.100.159 25/01/2025 Roubaix (59) OVH SAS 5.196.113.12 02/02/2025 Roubaix (59) OVH SAS 137.74.181.249 08/02/2025 Saint-Grégoire (35) OVH SAS 137.74.181.248 15/02/2025 Saint-Grégoire (35) OVH SAS J'ai bloqué définitivement ces IP (que je laisse volontairement visibles ici. Si la modération n'y tient pas, elle peut me le dire et je les supprimerai...). Mais je suis conscient que ça ne sert pas à grand chose car ce sont certainement des IP temporaires venant de VPN. On remarque immédiatement un fournisseur d'IP qui revient quasiment toujours : OVH SAS. Et des localisations géographiques constantes. Je ne sais pas trop quoi en déduire. Alors lisez et appliquez les conseils de Fenrir et de .Shad. ! Ce sont des mines d'or ! C'était mon témoignage pour dire que la sécurité du NAS est un point à ne pas négliger.1 point

-

[DS415Play] Disques durs HS à répétition

Je pense que oui si la suite est la réinstallation de DSM. Le lien que vous donnez c'est dans le cas où DSM est en défaut et que vous souhaitez conserver les données. Cette fonction ne règle en aucun cas la taille des partitions. Elle se contente de refaire une installation de DSM sur les partitions existantes.1 point

-

Synology DS916+ qui ne s'allume plus 😱 -> Alimentation HS

Bonjour ! Je pense avoir le même problème sur mon 918+... Après 7 ans de bons et loyaux services, il s'est éteint ce matin à 9h36 (RIP). Je viens d'essayer de le redémarrer, la led power bleue clignote parfois 4 fois, parfois 3 et ça se coupe. J'entend un petit siflement électrique. Je retire HDD ; NVMe ; LANs et DD ext et là il démarre et est joignable sur le réseau. Je rebranche tout et bug de nouveau. Impossible à booter. Dans mon cas la led de l'alimentation est alumée et diminue de temps en temps. Alim en commande. J'espère que ç'est ça ! Mais bon après 7 ans c'est déjà beau ! @Lelolo merci pour le lien ! Edit : alimentation changée le 12/03 et NAS redémarré sans probleme depuis.1 point

-

Présentation de Sandrine

1 point@monevasionamoi, bienvenue sur la communauté ! Tu trouveras plein de tutoriels pour faire tes premiers pas et je te recommande celui consacré à la sécurité sous DSM 7. Le DS923 est un beau joujou en effet, profites en bien.1 point

-

SOS

1 pointBonjour et bienvenue. Un petit tour par la case « presentation » serait bienvenue et nous permettrait de connaître ta configuration. et tu peux également supprimer les deux autres versions de ton post en triple exemplaire …1 point

-

Migration DS211+ vers DS224+

1 pointBonjour @Manu Rossi, Pour la sauvegarde des données il faut faire avec Hyperbackup et pas drive voir ici https://kb.synology.com/fr-fr/DSM/tutorial/How_to_migrate_between_Synology_NAS_DSM_6_0_Hyper_Backup Ensuite il te faut supprimer les partition de sur tes disques sinon le nas va voir que tu as deja un DSM dessus donc migration pour lui et c'est ce que tu veux pas faire. Apres c'est la procédure normale. Si j'était toi je ferais des capture d'écran en plus de la sauvegarde cela peut être utile. Ton site est hébergé ou ( je suppose sur le nas ?). A ta question je ne sais pas y répondre car j'ai pas de site perso sur mes Nas. il faudrait pose la question aux autre personne du forum Enfin la procédure en général pour la migration https://kb.synology.com/fr-fr/DSM/tutorial/How_to_migrate_between_Synology_NAS_DSM_6_0_and_later1 point

-

[TUTO] [Docker - macvlan] Pi-Hole (V6)

A priori il y a beaucoup de variables à modifier : https://docs.pi-hole.net/docker/upgrading/v5-v6/ Certaines ne sont pas documentées, c'est le gros reproche que je fais à la doc pi-hole qui n'est pas exhaustive. Par exemple : https://discourse.pi-hole.net/t/ftlconf-local-ipv4-variable-no-longer-being-used-in-v6/76657/4 Et j'en ai d'autres que j'utilise qui ont été purement supprimées sans information sur leur remplaçant éventuel... Je suis une formation qui me prend une bonne partie de mon temps cette année, mais à partir de Juillet ça devrait aller mieux. Pour l'instant ça restera en v5 le temps que je puisse me poser et jeter un oeil à tout ça. 😄 Si comme moi vous n'avez pas la possibilité d'y regarder maintenant, pensez à sortir pi-hole des mises à jour automatiques de watchtower, si vous l'utilisez. 😉1 point

-

Présentation de CVT

1 pointBonjour @CVT soyez le bienvenu dans notre forum. Pour info, j'ai le même nombre de printemps ☺️1 point

-

[TUTO] [Pas-à-pas] Sécurisation du NAS - pour DSM 7

Sauf erreur, ce champ est toujours obligatoire puisqu'il sert à contacter le propriétaire. Ca ne change strictement rien dans le renouvellement auto. C'est juste que LE ne veut plus gérer l'envoi de messages pour signaler l'expiration proche des certificats. https://letsencrypt.org/2025/01/22/ending-expiration-emails/1 point

-

DSM 7.2.1 update 7 et DSM 7.1.1 update 8

Pour ceux qui ne veulent pas ou ne peuvent pas basculer sous DSM 7.2.2 1. DSM 7.2.1 update 7 Amélioration : Ajout de la prise en charge de la vérification des certificats des serveurs LDAP lors de la connexion à un annuaire : La vérification des certificats pour C2 Identity Edge Server n’est pas prise en charge. Cette configuration ne peut pas être sauvegardée dans la sauvegarde du système DSM ou dans Hyper Backup. Non indiqué mais corrige la faille sous la référence Synology-SA-25:01. 2. DSM 7.1.1 update 8 Amélioration : Ajout de la prise en charge de la vérification des certificats des serveurs LDAP lors de la connexion à un annuaire : La vérification des certificats pour C2 Identity Edge Server n’est pas prise en charge. Cette configuration ne peut pas être sauvegardée dans la sauvegarde du système DSM ou dans Hyper Backup. Problèmes corrigés : Le système pouvait afficher un statut incorrect dans les paramètres de notification par e-mail. Certains paquets ne s’affichaient pas après l’installation. Non indiqué mais corrige la faille sous la référence Synology-SA-25:01. 3. Liens Synology-SA-25:01 DSM (PWN2OWN 2024) => https://www.synology.com/en-us/security/advisory/Synology_SA_25_01 Centre de téléchargement => https://www.synology.com/fr-fr/support/download Archives officielles => https://archive.synology.com/download/Os/DSM/1 point

-

DS720+ - Ajout d'un disque dur 12To

Toujours pas. Le seul moyen de se protéger contre la perte de données est la sauvegarde. Le RAID1/SHR n'assure que la continuité de service.1 point

-

Plex : Convertir automatiquement

1 pointParce que ta tv n'a pas assez de ressources cpu et que les softs Sur tv sont souvent pas à jour. Achete une box Xiaomi 2nd gen, une Shield NVIDIA ou une Apple tv. Plus de souci.1 point

-

[TUTO] Mise à jour automatique des images et conteneurs Docker

Grace à ce tuto j'ai installé Watchtower aujourd'hui et j'ai reçu un premier e-mail 😀 Désolé pour le déterrage mais cela prouve qu'il est toujours d'actualité. Merci @.Shad.. Je vais maintenant, comme conseillé, me plonger dans la documentation officielle. C'est plus facile lorsque le container tourne correctement, il n'y a pas de stress sauf à tout casser !1 point

-

DS720+ - Ajout d'un disque dur 12To

Oui mais encore une fois plus grand ne veut rien dire 😉. Il faut préciser plus grand ou égal à 12To. En dessous ça ne fonctionne pas.1 point

-

DSM 7.1.1, pas de proposition de mise à jour

Cette indication apparaît aussi pour les versions suivantes de DSM 7.2 : 7.2.1 : https://www.synology.com/fr-fr/releaseNote/DSM#ver_69057 7.2.2 : https://www.synology.com/fr-fr/releaseNote/DSM#ver_72806 Je ne sais plus si j'avais dû les installer manuellement sur le DS718+.1 point

-

DSM 7.1.1, pas de proposition de mise à jour

@PiwiLAbruti C'était uniquement pour le passage de 7.1 à 7.2. Je n'en ai jamais compris la raison. Après, les notifications arrivent normalement, du moins sur mon 718.1 point

-

DSM 7.1.1, pas de proposition de mise à jour

Synology a indiqué dans les notes de mise à jour de DSM 7.2 que les NAS suivants ne recevraient plus de notification de mise à jour : Source : https://www.synology.com/fr-fr/releaseNote/DSM?model=DS218%2B#ver_645701 point

-

[TUTO] Préparation des disques avec Badblocks

Bonjour @koblar, Si je me trompe pas le DSM c'est moins de 10Go ( entre 3 et 6 Go), pares il faut rajouter la partition de swap et celle qui sert a faire les volumes. Essai de l'installer sur un 70Go tu ne risque rien. Pour le disque de Synology le badblock doit fonctionner car Synology me fabrique pas ces disques dur. C'est soit du WD ou du Seagate rebadgé1 point

-

Tout ce que vous avez toujours voulu savoir sur les réseaux sans jamais oser le demander

Les trois premiers (AH, GRE, et ESP) sont des protocoles liés aux VPN. Pour un protocole VPN comme IPsec, par exemple, il est nécessaire de diriger le protocole ESP vers le serveur VPN situé derrière la box. ICMP est un protocole de contrôle auquel appartient notamment le fameux ping (Types 0 et 8).1 point

-

Tout ce que vous avez toujours voulu savoir sur les réseaux sans jamais oser le demander

Il faut réduire la plage DHCP (ou la modifier c'est selon) de sorte que le routeur puisse attribuer une IP dans la plage DHCP pour les équipements sans baux statiques et une IP hors de la plage pour les équipements avec des baux statiques. Par exemple, votre routeur permet de travailler dans la plage 192.168.0.1 à 192.168.1.254. Vous réglez la plage DHCP de 192.168.0.101 à 192.168.0.254. Vous donnez des baux statiques aux équipements qui le nécessitent (un NAS par exemple, ou encore une caméra IP) dans la plage 192.168.0.2 à 192.168.0.100. Ainsi, tout équipement sans bail statique ne pourra pas prendre une IP dans la plage hors DHCP puisque le routeur lui attribuera une IP de 101 à 254. Mais il faut savoir que tous les routeurs ne permettent pas de créer des baux statiques en dehors de la plage DHCP. Si le votre ne le permet pas, vous n'aurez pas le choix que de travailler dans la plage du DHCP. Une redirection de port est, comme son nom l'indique, la redirection d'un port particulier vers un équipement particulier. Prenons l'exemple du port DSM 5001 (bien qu'il ne soit pas recommandé de donner un accès à DSM par le web). Ce port est dirigé vers l'IP statique du NAS (admettons 192.168.0.10). Si vous voulez atteindre DSM de l'extérieur votre URL sera : https://<votreIPpublique ou votrenomdedomaine ou votreDDNS>:5001. Votre navigateur va envoyer la requête vers votre routeur en indiquant le port avec lequel il souhaite communiquer. Le routeur qui reçoit la requête détecte qu'elle concerne le port 5001 et qu'elle doit être redirigée vers le 5001 du NAS.1 point

-

[TUTO] [Docker - macvlan] Pi-Hole (V6)

Salut, Je me rends compte que je suis encore en 2024.07.0. Je vais regarder ce week-end ce que ça donne. Si vous avez upgrade et que vous le regrettez, restaurez vos fichiers depuis une sauvegarde avec une version adéquate (2024.07.0 fonctionne par exemple).1 point

-

Rs18016xs+ impossible de redémarrer

Bonjour @boris21dd, Oui tu peux lire les données sur un PC par contre vue que tu as un rs18016xs+ , il te faudra brancher les 8 disques sur une carte Sata avec 8 ports (pas facile à trouver) . Mais sur un autre nas Synology avec 8 emplacements de disques ou plus tu peux remonter les données. Si ton nas est HS regarde si tu peux pas faire marcher ton assurance Habitation. Autre question tu n'avait pas éteins le nas avant de le débrancher ?1 point

-

Rs18016xs+ impossible de redémarrer

Sans être certain de mon coup, juste laisse débranché le bloc d'alimentation du NAS et laisse comme ça pour une nuit, ensuite rebranche et rallume le NAS, j'ai déjà eu ça dans le passé sur des cartes mères. Vérifie le voltage sur ton bloc d'alim avec un multimètre. Au vue des symptômes que tu décris il est possible que ta carte mère soit flinguée. Pour tes disques oui il est possible de les lire depuis un linux, pas d'inquiètude pour tes données.1 point

-

Difficultés dans la gestion des droits

1 point

-

Ajout d'un SSD pour le cache et apport en performance ?

1 point

-

[ Panne ]Ce groupe de stockage est dégradé

@narchymaster, Dans la 1er capture que tu as posté sur le test smart/onglet historique en bas tu as un section information clés des disque. Si tu la déploie tu as tous le passif de ton disque à savoir les secteur défectueux. Si non, comme disent les intervenants plus haut il faut changer le disque dur pas le choix.1 point

-

[ Panne ]Ce groupe de stockage est dégradé

c'est celle que j'ai aussi. Je tiens environ 15min avec mon 220+ et mon ds416play + 2cameras Poe, box internet et switch. Je pense que tu pourrais aller jusqu'à 30min juste avec un Syno. Le temps que tu tiens au final ça n'a pas beaucoup d'importance, le but étant de protéger le NAS en cas de coupure électrique, donc même avec 5min d'autonomie le temps que le NAS s'arrête proprement ça suffirait en vrai1 point

-

[ Panne ]Ce groupe de stockage est dégradé

1 point

-

[ Panne ]Ce groupe de stockage est dégradé

Ton disque est certainement encore sous garantie, il y a en général 3 ans de garantie, tu peux faire une déclaration de panne chez le constructeur directement1 point

-

[ Panne ]Ce groupe de stockage est dégradé

Oui, généralement c'est très mauvais signe ... Mais un disque déclaré mort pour le NAS peut encore avoir une seconde vie (comme disque externe par exemple), en ayant conscience de sa faiblesse potentielle (en ne lui confiant donc pas des données précieuses ...)1 point

-

[Résolu]Impossible d'obtenir la liste des dossiers partagés

Vous pouvez très bien mapper vos dossiers directement dans l'explorateur. Perso, je n'ai jamais utilisé l'assistant et je ne sais même pas comment il fonctionne. Choix : ce PC, connecter un lecteur réseau, choisir la lettre du lecteur, chemin : //IP du NAS/nom du dossier, valider les deux lignes en dessous, entrer les identifiants, choisir de reconnecter au prochain démarrage et c'est tout.1 point

-

Mise en route NAS neuf

1 pointPour le badblock il faut un nas initialisé ( un disque avec le DSM dessus) pour pouvoir lancer let tes sur l'autre disque Sinon avec le logiciel constructeur c'est avec un Pc ou Mac et un boitier Usb.1 point

-

Mise en route NAS neuf

1 pointBonjour @koblar, Pour la 1er question j'aurais tendance à dire Oui; c'est ce que je fait dans 99%des cas lors de installation d'un nouveau nas ou le remplacement d'un disques. Soit badblock ou le logiciel constructeur. Pour la deuxième question tu as ces deux tutos.1 point

Ce classement est défini par rapport à Bruxelles/GMT+01:00